单位时间内验证想法的数量,对于AI的发展至关重要。但相比于互联网时代,AI时代验证想法的成本要高很多,而这个成本的来源主要来自于算力硬件。

现有的主流AI算力硬件来自于NVIDIA,它有CUDA生态,但算力芯片迭代慢,且成本越来越高昂。在NVIDIA的生态之外,发展最好的是Google的TPU生态,Google已经在TPU搭建的算力基础设施上训练出了Gemini 3.0 Pro这种Sota级别的模型。

而在TPU背后,有一项技术引人注意,就是AlphaChip,它是一个芯片设计领域的AI系统。使用传统方法,设计一款尖端的数据中心处理器可能需要数年时间,而AlphaChip能在六小时内完成部分半导体组件的设计。AlphaChip参与了Google TPU过去4代的设计,并已被联发科等外部半导体公司采用。

AlphaChip的核心设计者Anna Goldie和Azalia Mirhoseini不久前创立了一家创业公司,它做的事情是为下一代人工智能构建计算基础,利用AI和分布式计算,大幅缩短芯片的开发周期,消除制约AI发展的硬件瓶颈,让定制化芯片变得触手可及。

这家叫Ricursive Intelligence的公司创立于2025年12月初,当时它以7.5亿美元的估值完成了3500万美元的种子轮融资,Sequoia Capital领投。

近日,它又完成由Lightspeed Venture Partners领投的3亿美元A轮融资,投后估值40亿美元。参投方还包括DST Global、NVentures 、Felicis Ventures、49 Palms Ventures、Radical AI及Sequoia Capital。

将AlphaChip应用于多代Google TPU后,它的创造者要让定制化芯片普惠

传统的半导体设计,有两大痛点:设计流程缓慢,设计成本高昂。

设计流程的时间,成熟制程节点需要12-24个月,而5nm或3nm等前沿制程则需18-36个月。

设计成本,7nm芯片的平均成本为2-2.5亿美元,5nm为4.5-5亿美元,3nm则高达6-6.5亿美元。

而在设计成本中,50-70%是人力成本,另有5-15%的支出用于电子设计自动化 (EDA) 工具。

基于这种高昂的成本,当芯片的设计或制造出现延迟时,也会让行业大受损失。例如Morgan Stanley在2024年8月的一份简报指出,NVIDIA Blackwell芯片数月的延迟可能仅在2025年就造成超过100亿美元的收入损失。

可以看到,芯片的设计成本主要来自人力和EDA工具。一方面,传统EDA工具有昂贵的许可费用,另一方面,在设计芯片时,需要大量专业人士在半导体设计上反复迭代,试图实现“设计收敛”——即打造出一种既满足所有必要约束条件,又达成预期目标的集成电路。

如果有一种工具能让芯片设计的时间缩短到数天,而非2-3年,同时让芯片设计的成本不再是数亿美元,会怎么样?那么芯片的迭代速度将大大加快,定制芯片的成本也会降低,AI发展与半导体能力之间的鸿沟将被填平。

这件事情,Ricursive Intelligence的创始人Anna Goldie和Azalia Mirhoseini在Google已经做了很长时间。

Ricursive Intelligence的创始人Anna Goldie和Azalia Mirhoseini,图源:Ricursive Intelligence官方视频截图

2018年,Google Brain有一个名为“登月计划”的项目,Ricursive的两位创始人当时就想尝试用AI进行芯片设计,结果这个想法与Jeff Dean不谋而合,于是她们开始了这个项目。

她们经过探索,瞄准了布局规划(Floorplanning)这个方向,布局规划是将芯片组件放置到硅片上的过程。这个过程的复杂性源于输入问题规模的巨大,比如对于芯片上的一个区块 (block),需要优化的可能包含数百万个节点,所有这些节点都需要被放置和布线。而且必须确保约束条件,比如PPA(功耗、性能、面积)得到优化,并满足台积电等厂商给出的极小工艺节点尺寸下的所有限制。

她们与Google的TPU团队紧密合作,每周都向TPU团队展示数据。具体做法是,TPU团队用商业工具生成自己的布局,然后她们展示自己用AI生成的布局,她们需要证明自己的布局在每一个指标上都更优秀,TPU团队才会选择它。

最终,她们将自己的芯片布局,一路推进到了实际产品中,完成了流片等所有环节,而她们的成果,就是AlphaChip。

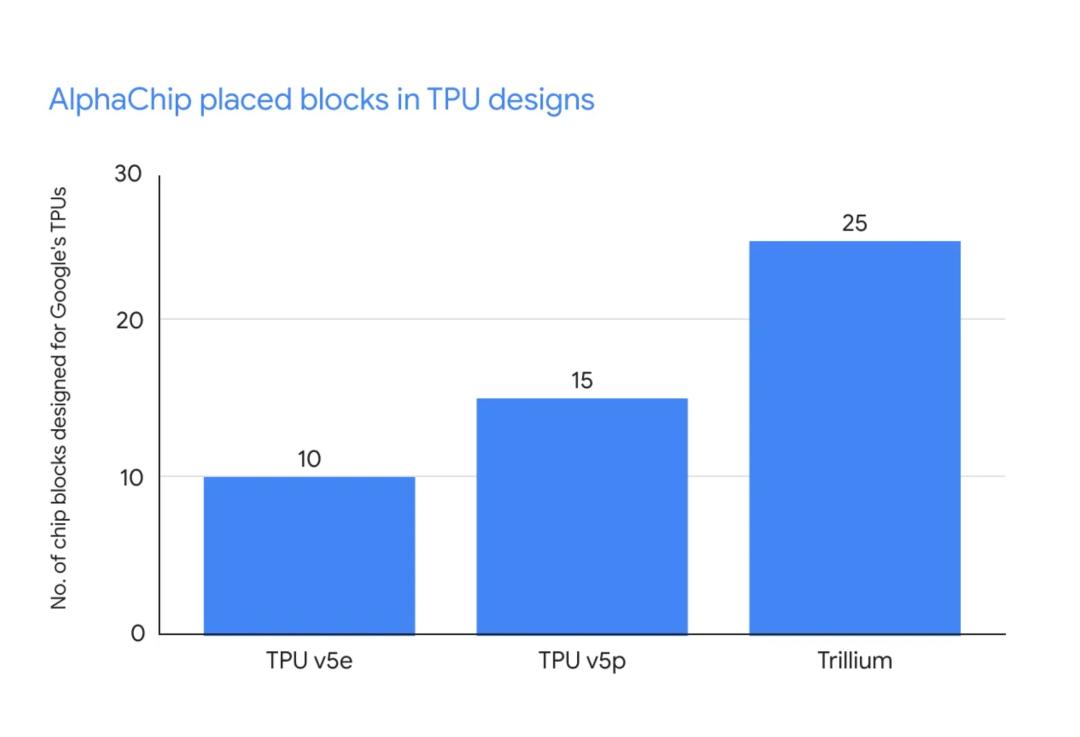

TPU每一次迭代,AlphaChip参与的芯片区块就越多,图源:Google

AlphaChip被应用到从TPU v5e及之后的每一代TPU中,并且应用于越来越多的芯片区块(一块芯片通常包含几十个区块),覆盖了更大的面积。

在这个过程中,她们还发现了类似Alpha Go的“第37手”那种超越人类经验的现象。在芯片设计中,人类倾向于采用网格般的规整结构,而AlphaChip的设计截然不同,其形状更具“有机感”,它设计的芯片布局有时会弯弯曲曲,但是相比规整的结构,这种弯曲的设计,有时就是能减少线长,进而降低功耗和时序违例。

在算法方面,AI这种自我改进的特性,随着解决问题的增多而变得越来越好时,它变得势不可挡:AI可以见识更多的数据点,解决比任何单个人类一生所能触及的还要多得多的芯片优化问题。

当发现这种迹象后,Anna Goldie和Azalia Mirhoseini认为创业的时机已经成熟,于是出来创业。她们组建的团队只有10人左右,但是成员们均来自Google DeepMind、Anthropic、Apple和Cadence(EDA软件巨头),涵盖AI、系统和芯片设计等领域。

构建“AI赋能芯片设计,芯片设计反哺AI”的递归循环

Ricursive Intelligence中的Ricursive,意思是递归。这其实是Anna和Azalia在做AlphaChip时发现的一种“AI赋能芯片设计,芯片设计反哺AI”的递归循环:AlphaChip在TPU上进行训练,然后被用来设计下一代TPU,再用新一代TPU训练下一版AlphaChip,并以此为基础不断迭代。

她们为公司规划了三个发展阶段。

第一阶段,攻克芯片设计的关键瓶颈,将流程显著缩短至数周。此前,每一个数据点原本可能需要人类花费数周时间来生成,但AI能在短时间内生成很多个,这样人类就可以去探索:我们真正想要的是什么?

第二阶段,实现端到端的设计。即给定一个工作负载 (workload),能否完成从头到尾的芯片设计,一直到生成“GDSII文件”——这是送交台积电等芯片代工厂进行制造的最终格式。

由于芯片设计过程的复杂性,能够负担得起定制化芯片的公司数量非常有限。当芯片设计的成本降低到一定程度,从AI硬件、机器人、自动驾驶汽车到太空探索等各个领域的任何公司,都有机会根据自己产品的需求定制芯片,这将引发定制化芯片的“寒武纪大爆发”。

在第三阶段,进行垂直整合:构建自己的芯片,训练自己的模型,利用AI设计出能更好、更快运行AI的芯片,再用这些芯片创造出能力更强、效率更高的新一代AI,完成“AI赋能芯片设计,芯片设计反哺AI”的递归循环。

Anna和Azalia为Ricursive设定的愿景,是将现在的“Fabless”(无晶圆厂)模式,推进到“Designless(无设计)” 模式。“Fabless”的典型代表就是NVIDIA,它现在是市值最高的科技企业之一。“Designless”,则意味着不仅外包制造,更外包整个芯片设计流程,将一个想法直接转化为可供制造的设计方案。

目前,芯片设计市场由Cadence和Synopsys主导,两家公司的年收入均达50-60亿美元,市值约在900-1000亿美元之间。如果Ricursive能够颠覆它们,本身就已经足够有想象空间。

而Ricursive本质上是将芯片设计从架构设计、RTL、验证到物理设计的全流程自动化,这里的自动化将解锁一些人类从未探索过的新颖芯片设计,更进一步,将解锁一波硬件创新的浪潮。

当芯片设计的成本指数级下降,将极大程度释放AI行业的创新能力

AI时代,顶尖公司们的人才密度相比互联网时代更高,想法并不算稀缺,而验证想法的成本主要成本来自算力硬件。

AI算力的缺乏,对于创新的限制,主要有两方面。

首先是模型层面,每次训练模型的算力成本,让模型的迭代相对缓慢,而当模型训练出以后,推理算力的限制,又让AI产品的推广和服务之类没有那么顺利(好几家头部AI创业公司因为算力不够而出现服务限制或中断)。

其次是AI硬件终端层面,无论是机器人还是智能可穿戴硬件,它们的设计都要围绕芯片展开,因为芯片直接影响了硬件终端的体积、续航以及最重要“智力”。

如果定制化的AI芯片,设计成本降低到一定程度,设计时间缩短到几天,那么将是对整个AI行业创新能力的极大释放。

想象一下,对于云端AI,可以针对不同类型和大小的企业负载,设计定制芯片,更精细化和高效地满足需求。对于AI硬件终端,在产品定义时,形态、大小和功能的设计可以更自由,可以不必再如履薄冰的让体积,性能和续航达到那么微妙的平衡。

AlphaChip本质上是基于强化学习的Agent,构建这类Agent最重要的是搭建环境和设定奖励信号。它对于数据有要求,但是只要环境和奖励信号设定好后,也可以使用合成数据。中国公司要追赶Cadence这样的公司,在积累上略显不足,但是打造AI设计的Agent,似乎追赶的目标就在前方不远处。