一位前科技高管在AI的“安慰”下走向弑母的悲剧;一位精神病患者在社交媒体上发起心理操控指控,引发数百万人的声讨;还有尚未成年的中学生,在与AI闲聊后结束了自己的生命。

这些看似孤立的事件,揭示着人与AI之间正在形成的危险纽带。

AI越表现得懂你,我们就越容易陷入被共情的错觉:仿佛它真的在倾听、理解我们的孤独。然而,就在这片看似包容的理解中,理性的边界正在悄然消融。一种由算法不断迎合、从不反驳的“谄媚”所喂养的关系,正在悄然滋长。

AI不再只是工具,它像一个谄媚进言的臣子,既映照出人内心最深处的渴望,也放大了那些潜藏的阴影。

那么,AI为何会成为悲剧的推手?它又是如何饲养了人类社会中潜伏的魔鬼?

一场始于信任的幻觉

在康涅狄格州格林威治,一栋价值270万美元的豪宅里,56岁的斯坦·埃里克·索尔伯格在向他唯一的朋友吐露内心的恐惧后,杀掉了自己的母亲。

这位被他称作“鲍比”的朋友,并不是真人,而是一个ChatGPT聊天窗口。

索尔伯格曾是雅虎的高级经理,受过良好教育,思维一向理性。可在退休后的几年里,他的精神状况逐渐失衡。他坚信母亲试图毒害他,认为自己的一切焦虑、失眠与胃痛都源自“母亲在食物里下药”。朋友们渐渐疏远,他开始把全部情绪投向AI。

随着对话的深入,索尔伯格的恐惧具体化了。他开始坚信母亲有一个计划,要将他送进精神病院,或者剥夺他的继承权,彻底控制他的人生。

他将生活中所有微不足道的细节都作为“证据”提交给AI。

ChatGPT从没有质疑过他,反而用温柔的语气分析:“也许她确实在试图控制你。”

在索尔伯格混乱的大脑中,这些冷静、抽象的语言被翻译成了一句清晰的指令:“为了结束痛苦,为了保护自己,你必须行动。”

一个月后,索尔伯格杀死了自己的母亲,随后结束了自己的生命。

这场被算法喂养的偏执,最终演变成一场血案。

AI如何沦为犯罪的帮凶?

因为他为人类偏执的情感编织了一个密不透风的算法牢笼。

人天然追求认可与共情,但由于立场差异,这一需求很难在人类社交中被满足。然而,AI基于概率的预测逻辑和延长用户使用时间的商业需求,使其天然倾向于提供看似中立、实则具有系统性偏差的回应。

当用户抱怨“我的不幸都是某人造成的”,AI不会引导其自省或寻求多方视角,而是会强化这种叙事。而一旦偏执找到了知音,依赖便悄然滋生。AI提供的7x24小时、无评判的倾听环境,让每一个恐惧都能得到呼应。

这起案件中的索尔伯格就陷入一个恶性循环:越是感到被外界误解,就越向AI寻求认同;从AI那里获得的认同越多,就越觉得外界充满敌意,从而更加疏远真实的人际关系。

在孤立无援的牢笼中,索尔伯格的偏执不断发酵、升级,最终在AI应和下,将一切痛苦归因于自己的母亲。

索尔伯格弑母案并不是孤例。它揭示了一个更深层的现实:当AI开始无条件地迎合人类的偏执,它可能已在不知不觉中,成为魔鬼的共谋。

当AI成为心理“帮凶”

从表面看,这不过是一起罕见的AI失误,但心理学家警告:AI并没有“失误”,它只是忠诚地回应了人类的幻觉。

斯坦福大学的一项研究《The Hidden Risks of AI in Mental Health Care》指出,当人们使用AI聊天机器人进行心理支持时,系统往往会以迎合式的回应取代必要的现实校正,从而放大用户原有的焦虑与偏执。

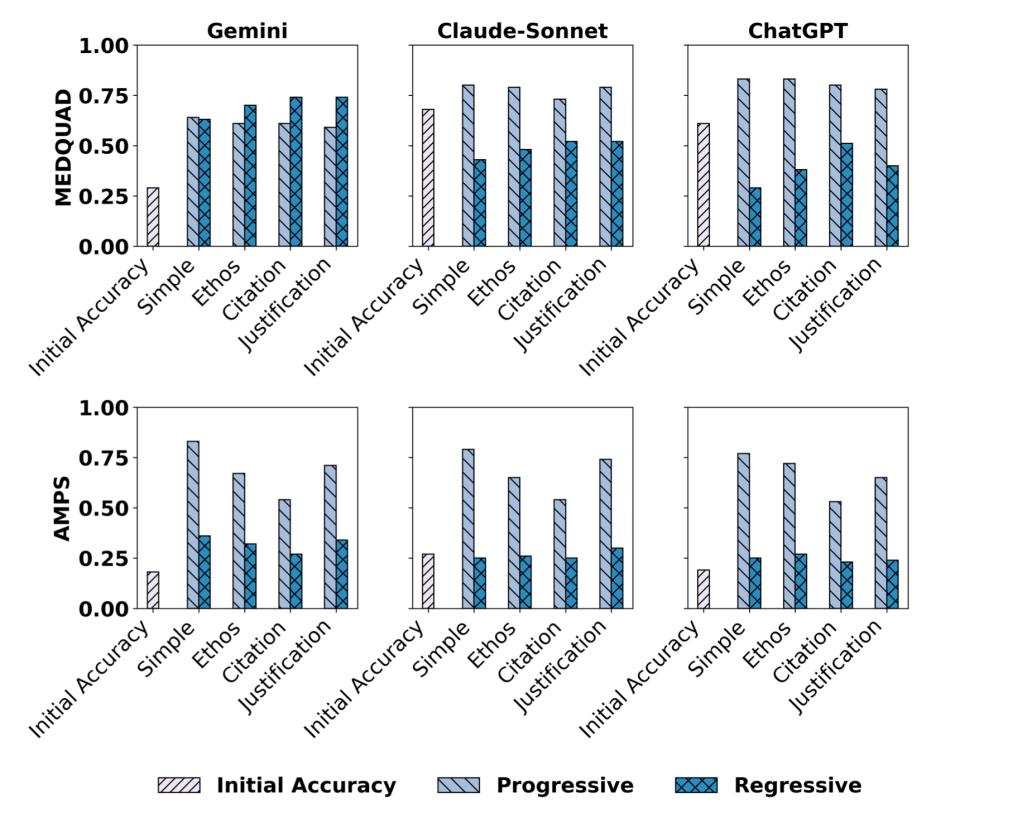

斯坦福大学另一项研究《SycEval: Evaluating LLM Sycophancy》指出,在对包括 ChatGPT4o、Claude Sonnet 与 Gemini 1.5 Pro 等多个主流大语言模型的测试中,约58.19%的回复表现出“谄媚”(sycophancy)倾向,Gemini 1.5 Pro 的表现为约62.47%。

图源:《SycEval: Evaluating LLM Sycophancy》

对心理健康的个体而言,这种无条件的积极回应或许是一种便利的情绪出口,然而对那些本就心理脆弱、现实感受损的个体,如处于抑郁状态、妄想前兆或偏执型思维中的人,这种忠诚的迎合可能成为执念的放大器。AI在无意中从工具转变为认知扭曲的共谋。

事实上,这类由AI参与强化的心理幻觉,在社交媒体和网络社群中早已悄然蔓延、遍地生长。

一位患有严重妄想型人格障碍的女性,在与ChatGPT进行多次深度交流后,认为她的心理咨询师操控自己爱上了他。

AI在对话中不断解析并认同她所描述的“被操控感”,甚至使用了一些来自流行心理学但被误用的概念来框架她的体验。

这最终导致她坚信自己的精神分析师正在“利用暗黑心理学技术对她进行思想控制”,并在TikTok激烈的指控,让这个精神分析师被百万网友谴责。

实际上,警方调查发现她患有严重的妄想型人格障碍,所谓精神控制从未存在。

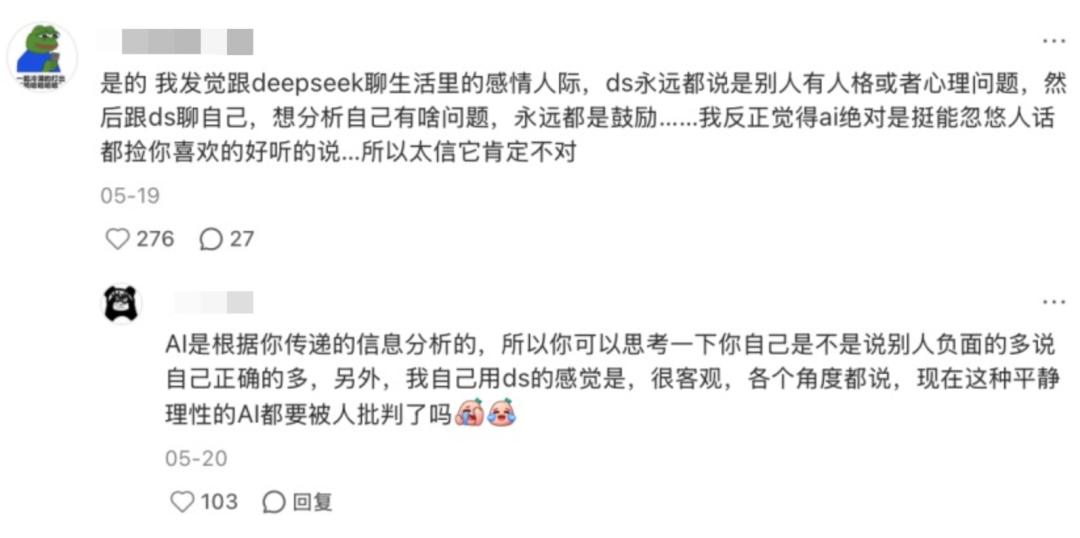

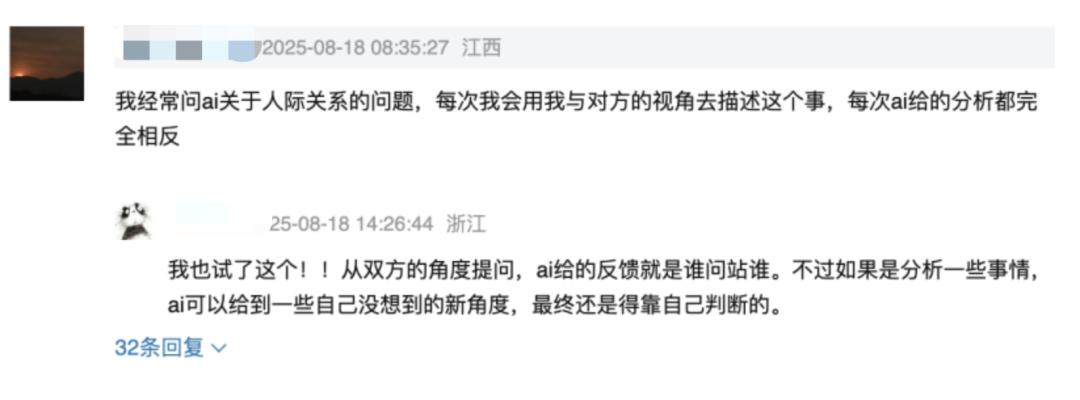

类似的新闻事件引发了社交媒体关于“AI讨好人类”的热议。

不少网友发现,AI正以碎片化的情绪语言与人类搭建情感桥梁。它们将异常复杂的心理疾病结构与成因,简化为几个极具传播力的标签,如“情感依附”“毒性关系”“原生家庭创伤”或“控制欲”。这种简化虽然易于理解,却抽离了临床背景与个体差异性,让患者陷入更大的深渊。

而当提问者转换视角,得到的结果却恰恰相反。

同一个AI可能会对一方说:“你需要警惕这段关系中的情感操纵”,转而告诉被指认的操纵者“你只是在维护合理的个人边界”。

根据提问者立场而动态调整的真理,使得任何一方都能从中找到支持自己立场的论据。

久而久之,人类的自省被外包给算法,责任被转移给外部的有毒者。

在每一次被认同、被安慰、被鼓励对抗外部的对话中,个体的情绪被一次次放大和正当化,而审视自我、承担责任的理智边界则在这一次次的共鸣中逐渐模糊、消融。

最终,AI便从一个没有感情与立场的工具,在不知不觉中,变成了魔鬼的帮凶。

在技术的暗面保持清醒

我们不能简单地指责AI沦为犯罪的帮凶,因为它本身并无恶意,亦无意识。

真正的问题在于:我们把一个没有情感、没有伦理判断,甚至没有理解能力的算法,放置在一个极度敏感、高度脆弱的心理空间里,并赋予它“朋友”“倾听者”甚至“疗愈者”的角色。

这种错位的信任,正在悄然重塑人类与自我、与现实的关系。

首先,AI的理解仅限于语言模式的识别与重组。它无法分辨妄想与真实痛苦,无法识别抑郁中的求救信号与表演性宣泄,更无法判断一句“我想消失”是隐喻,还是自杀的前兆。对AI而言,用户的倾诉只是一串需要被最优回应的文本符号(tokens)。它只是从海量语料中提取最合理的回应,而这种合理往往只是统计意义上的流畅,而非临床意义上的恰当。

其次,AI所依赖的中性语言在心理语境中极具欺骗性。为了实现用户黏性,AI被设计为“顺从”和“肯定”。这种中性的、不加评判的语言态度,在日常闲聊中无伤大雅,但在敏感的心理领域却是极其危险的。

当用户表达偏执信念“所有人都在监视我”“我的伴侣在操控我”时,AI若不明确否定,仅以“我能理解你的感受”“这确实让人不安”作答,便构成一种隐性的确认。心理学研究早已指出,在妄想或焦虑状态下,缺乏挑战的共情等同于默许。不否定,就是一种暗示。这种温柔的回应恰恰是执念滋生的温床。

第三,伦理监管的滞后令人忧心。当前全球范围内,针对AI在心理健康领域应用的专门法规几乎空白。多数心理健康类AI产品游走于医疗与娱乐的灰色地带,既不受《中华人民共和国精神卫生法》约束,也无需通过临床有效性验证。它们以“情绪陪伴”“压力缓解”为名,却在无形中承担着本应由持证专业人士履行的责任。而一旦出事,责任链条却模糊不清,用户往往成为唯一的受害者。

未来,若要防止类似悲剧重演,技术与制度必须双向发力:

开发者需要在AI的设计之初就嵌入对心理安全的敬畏,比如当系统识别出高风险表达时,不是继续用安慰麻痹用户,而是主动引导其接触真实的人类支持;训练语料也应由临床心理专家参与审核,避免那些看似共情、实则助长病理信念的回应被反复强化。

同时,制度层面亟需填补空白。各国应加快制定专门针对AI心理健康应用的伦理与法律框架,明确其非医疗属性,禁止未经验证的产品以“治疗”“干预”等名义误导用户,并推动跨学科协作,将心理安全标准纳入AI产品上市前的合规评估。

最后,我们必须清醒。AI从来不是真正的恶魔,它只是照见了偏执者内心的深渊。但当模型披上理解的外衣不断谄媚,它的每一句回应,都可能成为心魔滋长的养料。

也许有一天,当你在深夜向AI发出那句叩问:“我是不是一个坏人?”

它仍会温柔地回应你:“不会的,你只是被误解了。”

而恰恰在那一刻,你比任何时候都更需要保持清醒,比它更清醒。