近来,GPT-4.1关键人物揭秘了GPT-5进展,挑战在于平衡推理与聊天能力。与此同时,OpenAI首席研究官在新采访中,畅谈了通往AGI之路的关键要素。

GPT-5到哪一步了?

最近,GPT-4.1核心研究员Michelle Pokrass透露,构建GPT-5的挑战在于,在推理和聊天之间找到适当的平衡。

她表示,「o3会认真思考,但并不适合进行随意聊天。GPT-4.1通过牺牲一些闲聊质量来提升编码能力」。

「现在,目标是训练一个知道何时认真思考、何时交谈的模型」。

在长达50分钟的最新对谈中,Michelle首次对外介绍了更多关于GPT-4.1背后开发过程,以及RFT在产品中发挥的关键作用。

面对AGI的终极目标,OpenAI首席研究官表示,「AGI不仅仅是ChatGPT,还包含了很多东西」。

当前,OpenAI面对的不仅仅是技术挑战,还得在信任、伦理上找到平衡。

GPT-4.1研发背后

Michelle Pokers表示,GPT 4.1的目标是让开发者在使用时感到愉快。

有时候,为了优化基准测试而调整模型,结果看起来不错,实际使用却发现一些问题,比如模型不遵循指令、格式怪异,或者上下文太短。

团队花了很多精力与用户沟通,收集他们的意见,然后将这些反馈转化为研究过程中真正能用得上的信息。

研究人员会观察反馈中反复出现的主题,如指令遵循能力。

OpenAI内部也使用了这些模型,所以能感觉到模型在哪些地方表现得不好。

综合这些因素,团队可以确定哪些评估指标是客户真正需要重点优化的。

OpenAI有一款电子邮件产品,在处理邮件时能获得免费的推理服务。作为交换,公司能利用这些数据。

Michelle真的很喜欢看到人们构建的各种酷炫的用户界面。

团队在模型开发的最后阶段悄然加入了一项改进,就是大幅提升了UI和编码能力。

她也看到喜欢人们使用Nano的情况,它小巧、便宜又快。

Nano背后的假设是,能否通过廉价且快速的模型来大幅推动AI的普及?答案是肯定的。人们对和成本延迟曲线上的各种地方都有需求。

在提升模型性能方面,GPT 4.1聚焦长上下文和指令跟随。

长上下文处理能力是衡量模型在复杂任务中表现的重要指标,但生成有效的长上下文评估内容颇具挑战。

OpenAI致力于获取更多真实世界的长上下文评估数据,以提升模型在实际应用中的表现。

在模型应用中,模糊性处理是一大难题。

是向用户进一步询问信息,还是依据已有信息进行假设推理,这需要开发者能够灵活调整模型的策略。

GPT 4.1在这方面做出改进,增强模型的可操控性,减少因模糊性导致的困扰。

API出现错误时,模型可能卡顿,影响使用体验。

OpenAI通过改进训练算法和数据处理方式,让模型面对错误和异常情况时持续稳定运行。

GPT 4.1在代码编写能力上有显著提升,在局部代码修改任务中表现出色,但涉及全局上下文和复杂代码推理时,仍需优化。

例如,处理文件间复杂技术细节传递的任务时,模型的理解和处理能力有待加强。

在前端编码方面,团队不仅要求功能正确,还注重美观和规范,符合工程师的专业审美。

RFT新突破

微调技术在GPT 4.1扮演着重要角色,RFT(强化微调)的出现,为模型能力拓展带来新的可能。

与传统的SFT相比,RFT在特定领域展现出强大的优势。

在芯片设计、生物学和药物研发等领域,RFT的微调过程数据效率极高,仅需几百个样本就能取得良好效果。

在药物研发中,通过RFT可以利用独特且可验证的数据,让模型更精准地模拟药物作用机制,加速研发进程。

芯片设计领域,RFT能帮助模型更好地理解和处理复杂的设计规则,优化设计方案。

这些领域的共同特点是,虽然需要不断探索,但实验结果容易验证,与RFT的优势高度契合。

OpenAI首席研究官:通往AGI之路

在外媒TechINAsia最新文章中,通过采访OpenAI模型背后的人,向外界再次展示了OpenAI可预见的AGI的未来。

Mark Chen,这位华人研究科学家,在内部模型研发中扮演着举足轻重的作用。

在OpenAI的七年时间里,他从研究科学家逐步晋升为首席研究官,负责模型开发和公司整体研究工作。

他领导了多项里程碑式的项目——o1系推理模型、文本到图像模型Dall-E,以及融入视觉感知的GPT-4。

从金融到AI,意外的职业转折

Mark Chen的职业生涯,并非从一开始就锁定AI。

在MIT获得数学与计算机科学双学位后,他原本的计划是,继续攻读博士学位,成为一名教授。

然而,命运的转折点出现。

在计划合作的教授创立了一家对冲基金后,他改变了方向,随之加入了金融行业。

在这样高频交易的世界里,Mark Chen度过了6年。

他坦言,「这份工作在某些方面令人满足,但在其他方面非常不满足。你面对同样的竞争对手,大家都在追求更快,但你感觉不到自己正在改变世界」。

2016年,谷歌AlphaGo在一场历史性比赛中,击败了九段棋手李世石,其人类水平的表现甚至让AI专家震惊。

受此启发,Mark Chen通过实现Deep-Q神经网络复刻AlphaGo。正是这一尝试,让他彻底迷上了AI。

尽管没有博士学位,幸运的是,他通过OpenAI的驻留计划,幸运地迈入了这一领域。

找到AGI最佳平衡

在谈及AGI之时,Mark Chen表示,「我们采用非常广泛的定义,它不仅是ChatGPT,还包括了其他东西」。

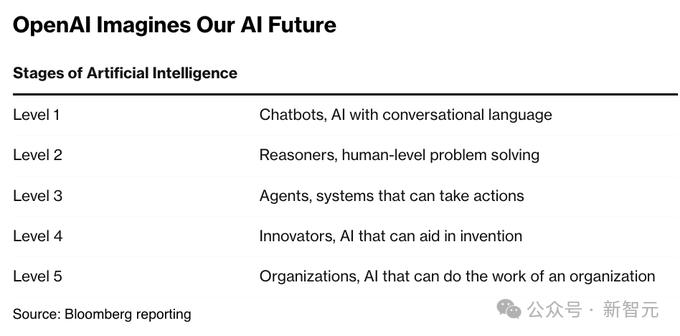

一直以来,OpenAI将AGI视为AI的圣杯,并制定了五级框架来实现这一目标。

而现在,他们已经到达了第三级,智能体AI(Agentic AI)——能自主执行复杂任务和规划。

Mark Chen介绍称,OpenAI近期推出的两款AI智能体产品,Deep Research和Operator尚处于早期阶段。

Operator在未来,速度可以更快,轨迹可以更长,这些产品代表了OpenAI对智能体AI的雄心。

他还强调,平衡短期产品发布与长期研究,将计算资源分配到OpenAI的整个项目组合中,是自己工作的核心,最终确保OpenAI在商业化与科学探索之间找到最佳平衡。

Mark Chen对OpenAI内部算法的优化充满信心。

他表示,自家的推理模型在训练时,使用的数据远少于预训练模型,但通过更多计算资源实现了高效性能。

由此,OpenAI在效率上不逊于谷歌Gemini 2.5等竞争对手。

回应开源

几天前,奥特曼在一次会议上称,预计今年夏天开源首个推理模型。

在采访中,Mark Chen同样透露,公司正计划发布GPT-2以来首个开源语言模型。

他认为,开源模型的优势在于推理能力和开发者对其进行优化,但也因安全措施较少,而存在滥用的风险。

面对DeepSeek等AI模型强势崛起,Chen显得从容不迫。

他表示,在AI领域最大的危险,是反应过度。OpenAI坚信自己的路线图,专于长期目标而非短期市场噪音。

最后,Mark Chen还为想要进入AI领域的年轻人提供了建议:「深入熟悉所有工具,永远保持好奇心」。

你玩的工具越多、越好奇,就越能理解其他人试图推动的领域,以及未来的正确方向。你必须保持领先。

这是一个变化很快的领域。你看到的许多被探索的事物,都是未来的瞥见。

参考资料:

https://www.techinasia.com/man-models-openais-research-chief-road-agi

https://www.youtube.com/watch?v=NNGbaiN1L7Y

https://x.com/slow_developer/status/1921248876687999153

https://x.com/jacobeffron/status/1920849638166315104