文|刘俊宏

编|王一粟

在AI大模型走向应用的时代,AI“卖铲人”英伟达又带来了最新的“参考答案”。

12月15日,英伟达正式发布了Nemotron 3系列开放AI模型。该模型系列包含Nano、Super和Ultra三种规模,模型主打效率和领先的精度,适用于AI Agent的应用开发。

对于这套模型,英伟达创始人兼首席执行官黄仁勋总结说:“开放创新是AI进步的基础。通过Nemotron,我们将先进AI转化成开放平台,为开发者提供构建大规模代理式系统所需的透明度与效率。”

本次发布的三个规模的模型,英伟达的设计目标非常明确,直指AI应用中的高效和节能。

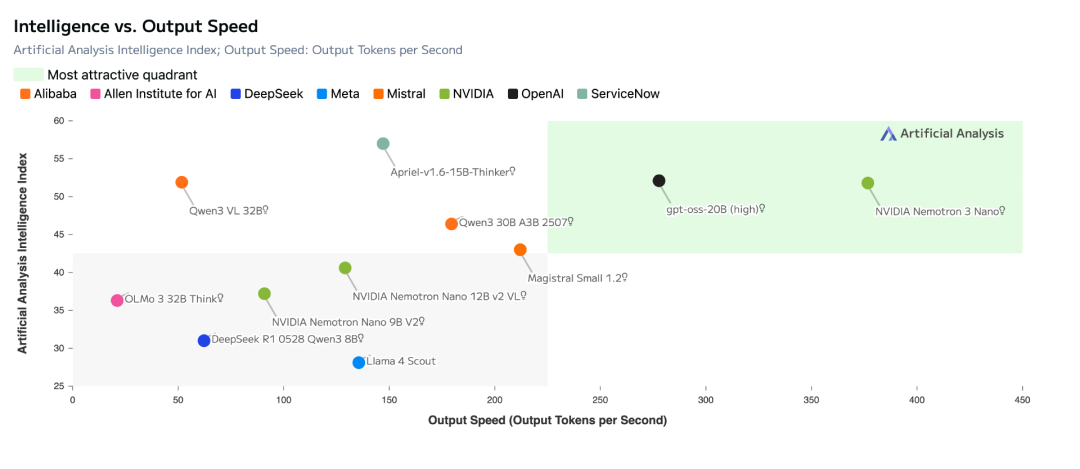

Nemotron 3 Nano模型目前已经上线。该模型参数总量为300亿,由于模型采用了独特的异构MoE架构,这使得每次运行时只需激活30亿参数。模型能按需使用,非常省电。相比上一代模型,Nemotron 3 Nano速度快4倍,成本低60%,非常适合写代码、总结文档、当智能助手等日常任务。此外,模型还支持100万token的上下文记忆能力。这相当于记住几本书的内容,保证模型在使用中不会轻易忘事。

Nemotron 3 Super模型,预计于2026上半年推出,主打多智能体协作完成任务。该模型参数总量约1000亿,每个token最多激活100亿参数,也是兼具了节能和高效。

Nemotron 3 Ultra模型,同样预计于2026上半年推出。主要面对高级推理引擎,服务于需要深度研究和策略规划的AI工作流,是Nemotron 3系列的“最强大脑”。该模型参数约5000亿,每个token最多激活500亿参数,适用于复杂的AI应用。

值得注意的是,Nemotron 3 Super与Ultra采用基于NVIDIA Blackwell架构的4位NVFP4训练格式,可显著降低显存需求并加速训练进程。这种效率使更大规模模型能在现有基础设施上进行训练,不会因更高精度格式而牺牲准确性。

简单来说,是就是之前训练一个大模型需要最新、最好的GPU集群才能兼顾准确性和效率。现在开发者可以在现有硬件上训练,不需要担心低精度会让AI“变傻”的问题。

英伟达推出Nemotron 3系列模型的想法,是想让开发者能根据特定工作负载选择更合适自己的开放模型。AI任务能在数十至数百个智能体间灵活扩展,同时在复杂工作流中获得更快速、精准的长时推理能力。

简单来说,就是英伟达为AI开发者提供了一套AI“积木”。应对一项“大工程”,开发者可以按需选择有小砖(Nano快)、中砖(Super稳)和大砖(Ultra强)。或者同时招募几十上百个“工人”(智能体)一起干活。

为了更方便开发者使用,本次英伟达在开源了模型之余,还开放了训练数据集和前沿强化学习库。

为了给开发者示范高性能特定领域智能体如何创建推理、编码及多步骤的工作流,英伟达本次公开了3 万亿token规模的全新Nemotron预训练、后训练及强化学习数据集。Nemotron Agentic Safety Dataset工具提供真实场景的遥测数据,帮助团队评估并提升复杂智能体系统的安全性。

为了加速AI开发进程,英伟达发布了NeMo Gym与NeMo RL开源库。这能为Nemotron 模型提供训练环境及后训练基础。在验证模型安全性和性能环节,英伟达还推出了NeMo Evaluator。目前这些工具,都已经在GitHub和Hugging Face平台上线。

开发工具层面,Nemotron 3 已获得LM Studio 、llama.cpp、SGLang 和vLLM支持。Prime Intellect与Unsloth正将NeMo Gym的即用型训练环境直接集成至其工作流,使团队能够更加快速、便捷地获得强大的强化学习训练能力。

为了方便Nemotron 3模型落地,AI云厂商们也做好了相应的准备。

目前,Nemotron 3 Nano已上线于Hugging Face平台,提供推理服务的厂商有Baseten、Deepinfra、Fireworks、FriendliAI、OpenRouter、Together AI等公司。Nemotron还上线了多个企业级 AI 与数据基础设施平台,包括Couchbase、DataRobot、H2O.ai、JFrog、Lambda 及 UiPath。此外,Nemotron 3 Nano将通过Amazon Bedrock(无服务器模式)在亚马逊云科技平台上提供给使用公有云的客户,并且也即将支持Google Cloud、Coreweave、Crusoe、Microsoft Foundry、Nebius、Nscale 及 Yotta。Nemotron 3 Nano 同时还可以用 NVIDIA NIM 形式提供,开发者可在英伟达自己的平台上选用。

总体来看,Nemotron 3 是英伟达想让AI被更多人使用的一次努力。作为算力供应商的英伟达,依然是为开发者降低AI门槛,做开源生态的姿态。毕竟,只有AI开发者能一起赚钱,英伟达的GPU才能卖得更多。