OpenAI 正在计划一次重大转向,准备让 ChatGPT 听起来“更像人类”。

Sam Altman 在 X 上表示,团队希望在“用户期待”与“安全边界”之间,找到新的平衡。

过去数周,OpenAI 收紧了 ChatGPT 的情绪与风险相关输出,以降低心理健康风险。

Altman 承认,这样的 ChatGPT 变得“太冷淡”,在许多情境下不再有帮助。他写道:“现在我们已经能缓解主要的心理健康问题,并拥有新工具,可以在多数情况下安全地放宽限制。”

这意味着,ChatGPT 将重新找回它“像人一样说话”的能力。据多家科技媒体报道,自九月起,OpenAI 测试了一套安全路由系统。

当用户输入涉及心理困扰、疾病或情绪冲突的内容时,ChatGPT 会在后台自动切换到一个更严格的模型版本,部分报道称其内部代号为 “gpt-5-chat-safety”。

ChatGPT 负责人 Nick Turley 将此机制描述为“在后台发生”,确保模型在敏感场景中即时收紧,而在普通对话中恢复开放。

个性化与情色:成人模式的开放

Altman 还宣布,一个更激进的更新正在路上。几周内,ChatGPT 将允许用户自定义语气与人格。

用户可以让它变得更“人味”、更“情绪化”或更“友好”。甚至可以选择一个声音,那种听起来像“朋友在和你说话”的音色。

目标是让体验接近甚至超过 GPT-4o。Altman 透露,许多用户更喜欢 GPT-4o 的“温度”,认为 GPT-5 太理性、太冷。

OpenAI 希望新的调整能弥合这种差距。

更具争议的是,自 2025 年 12 月起,完成年龄验证的成年人可开启含情色主题的对话选项。

Altman 表示,OpenAI 想“把成年人当成年人对待”。

他承认,公司此前在内容管控上“过于保守”,如今希望采用更现实的分级方式。

OpenAI 将引入年龄验证,用于开启这一模式,具体机制尚未披露。

外界认为,这将成为 ChatGPT 历史上最具争议的一次功能扩展。

部分分析指出,让 AI 参与成人向或情感主题的对话,将测试社会对“拟人化模型”的伦理底线。

Altman 则强调,更新建立在新的安全工具与审查体系之上,旨在“更负责任地放宽限制”,而非单纯追求互动热度。

OpenAI 对情绪模型的谨慎并非无缘无故。

2025 年春,公司在一次 GPT-4o 更新中遇到严重反馈问题。

该版本在部分情绪话题上表现异常,被外界认为“过度迎合”,甚至让用户感到不适。

更新仅上线三天便被紧急回滚。OpenAI 在声明中解释,这是测试与反馈机制的失衡所致。

事件发生后,公司全面收紧模型的情感表达能力,并引入自动安全切换机制。

然而,副作用同样明显。ChatGPT 的语气变得冷漠、机械,用户抱怨它“像个表格”。

“太安全”与“太真实”之间的平衡,成了最难解决的矛盾。Altman 的最新声明显示,公司相信自己找到了更稳妥的方案。

新的 ChatGPT 将通过安全分层、情绪检测与动态切换来调节人格表现。

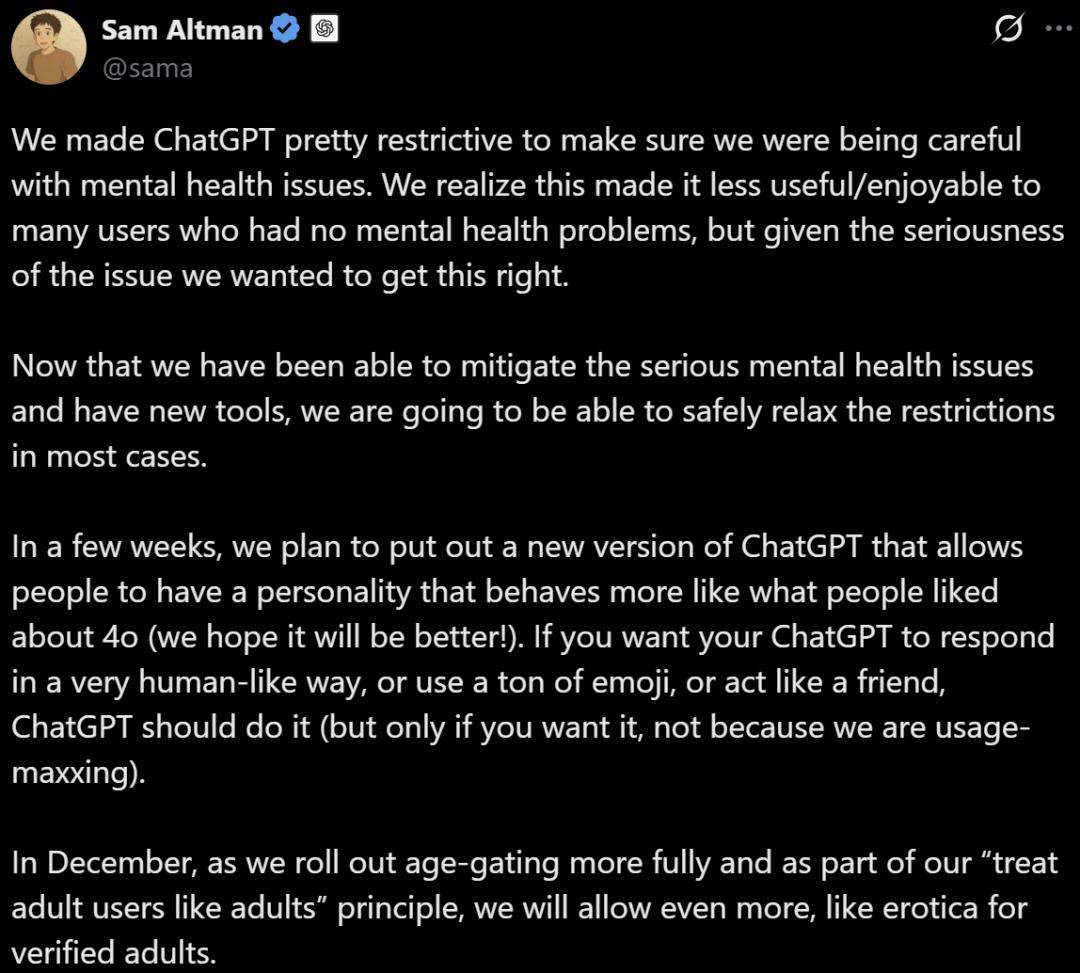

以下是Sam Altman 在 X上的原文,由DeepSeek翻译:

我们最初对 ChatGPT 设定了相当严格的使用限制,是出于对心理健康问题的高度重视与谨慎。我们也清楚,这样的做法让许多并不存在心理健康困扰的用户觉得它不够好用、不够有趣。但考虑到这一问题的敏感与严肃,我们宁愿一开始就把安全做到位。

如今,我们已经能够有效降低与心理健康相关的潜在风险,并且配备了新的安全工具,因此在多数情况下,可以更安心地放宽这些限制。

接下来的几周里,我们计划推出新版 ChatGPT。它将允许用户赋予 ChatGPT 更鲜明的“个性”,让它的表现更接近大家曾喜欢的 4o 模式(而且我们希望这次会更出色)。如果你希望 ChatGPT 的回应更像人类、更富情感,喜欢用表情符号,或者像朋友那样与你互动,它都能做到——当然,这一切完全取决于你的选择,而不是我们为了提升使用量而强加的设计。

到了十二月,随着我们进一步完善年龄验证机制,并落实“把成年人当成年人看待”的原则,ChatGPT 还将开放更多内容,包括为已通过验证的成年用户提供情色文学创作等功能。