图片来源:Kirillm / Getty Images

一项备受瞩目的人工通用智能(AGI)测试即将迎来破解的曙光,然而,测试的设计者却坦言,这一进展更多揭示了测试本身的缺陷,而非研究领域的实质性突破。

2019年,AI领域的领军人物弗朗索瓦·肖莱特推出了ARC-AGI基准测试,全称为“人工通用智能的抽象与推理语料库”。该测试旨在评估AI系统能否在未经训练的数据之外有效掌握新技能。弗朗索瓦声称,ARC-AGI是评估通用智力进展的唯一AI测试(尽管也有人提出了其他测试)。

直至今年,表现最佳的AI系统也仅能解决ARC-AGI中不到三分之一的任务。肖莱特将此归因于业界对大型语言模型(LLMs)的过度依赖,他认为这些模型并不具备真正的“推理”能力。

“LLMs在泛化方面存在局限,因为它们完全依赖于记忆,”肖莱特在今年2月的一系列帖子中写道,“对于任何不在其训练数据中的内容,它们的表现都会大打折扣。”

正如肖莱特所指出,LLMs本质上是统计机器。它们通过大量示例进行训练,学习这些示例中的模式以进行预测,例如识别一封电子邮件中“to whom”通常位于“it may concern”之前这样的规律。

肖莱特认为,尽管LLMs能够记忆“推理模式”,但它们不太可能基于新情况生成“新推理”。“如果你需要通过众多模式示例进行训练,即便这种模式是隐性的,以便学习可复用的表示形式,那实质上还是在记忆,”肖莱特在另一篇帖子中强调。

为了激励LLMs之外的研究,今年6月,肖莱特与Zapier联合创始人迈克·克诺普共同发起了一项100万美元的竞赛,旨在构建一个能够击败ARC-AGI的开源AI。在收到的17789份提交中,最佳得分为55.5%——相较于2023年的最高分提升了约20%,但仍未达到获胜所需的85%“人类水平”阈值。

然而,这并不意味着我们离AGI的实现又近了20%,克诺普指出。

今日,我们宣布2024年ARC奖的获奖者。同时,我们将发布一份详细的技术报告,分享从竞赛中汲取的经验(链接见下一条推文)。

最先进水平从33%跃升至55.5%,这是我们自2020年以来见证的最大单年增幅……

— François Chollet (@fchollet) 2024年12月6日

在一篇博客文章中,克诺普透露,许多提交给ARC-AGI的作品采用了“暴力破解”的方式寻找解决方案,这表明ARC-AGI任务中的“很大一部分”“并未包含太多对通用智力有用的信号”。

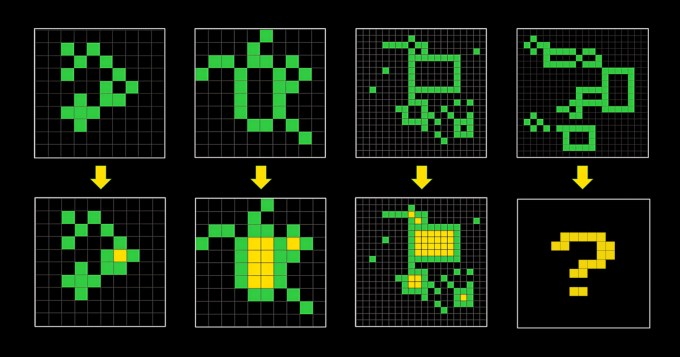

ARC-AGI由一系列类似谜题的问题组成,要求AI从一系列不同颜色的方块中生成正确的“答案”网格。这些问题旨在迫使AI适应其未曾见过的新问题,但目前尚不清楚它们是否真正实现了这一目标。

ARC-AGI基准测试中的任务示例。模型需解决顶部一行的“问题”;底部一行展示解决方案。图片来源:ARC-AGI

“自2019年以来,[ARC-AGI]一直未做改变,而且并不完美,”克诺普在其帖子中坦承。

弗朗索瓦和克诺普还因过分推崇ARC-AGI作为实现AGI的基准而受到批评,尤其是在AGI的定义本身正饱受争议的背景下。OpenAI的一名员工最近声称,如果将AGI定义为“在大多数任务上比大多数人更优秀”的AI,那么AGI“已经”实现。

克诺普和肖莱特表示,他们计划发布第二代ARC-AGI基准测试,以解决现有问题,并将在2025年举办一场新竞赛。“我们将继续引导研究界聚焦于我们认为AI领域最重要且尚未解决的问题,加速AGI的实现进程,”肖莱特在X平台上写道。

修复这些问题或许并非易事。如果第一代ARC-AGI测试的不足有任何启示的话,那么为AI定义智力将如同为人类定义智力一样,既复杂又充满争议。