划重点

① Sam Altman没有选择用“草莓”命名新模型,而选择用“OpenAI o1”,它预示着OpenAI提高模型准确性、降低幻觉的新开始。

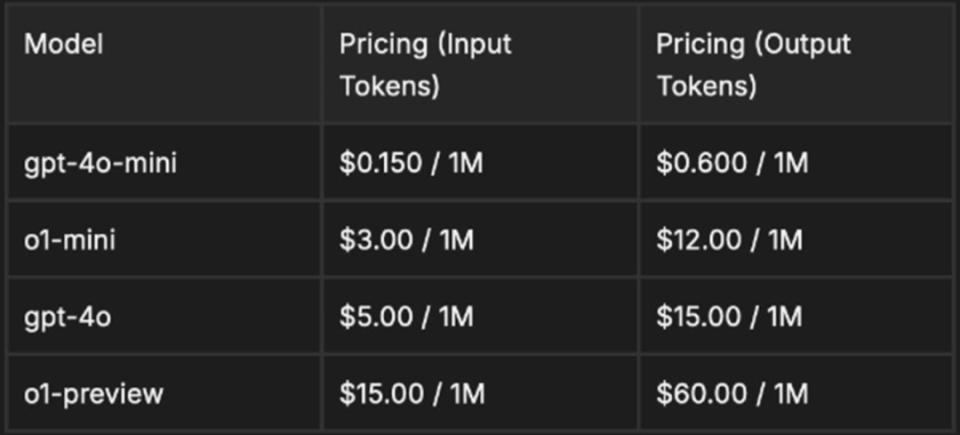

② 订阅用户可以不用重新付费、无缝衔接使用OpenAI o1,而API使用者则需要“花重金”的准备,API最终使用成本可能比GPT-4o高出1000倍。

③ OpenAI o1很可能采用了Self Play RL的方法,利用带有思维链能力的PRM提升了模型的推理能力。但它应该没有采用MCTS的方式。

④ OpenAI o1确实带来了从预训练scale up转向推理scale up的范式转变,但其有效领域暂时比较有限。对AI应用开发的提升也不显著。

Sam Altman种的草莓终于“熟”了。

9月13日,美国当地时间周四,OpenAI酝酿许久的新模型OpenAI o1(以下简称o1)问世,在正式发布之前,o1一直被外界称为“草莓”。

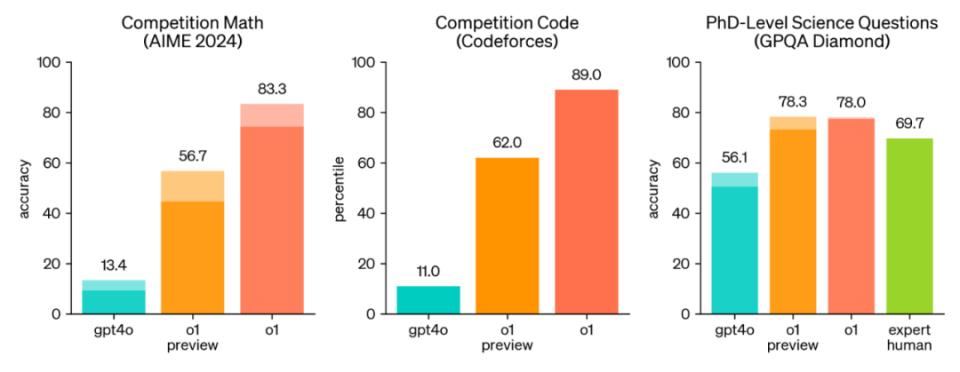

o1的核心能力在于复杂推理,目前有o1-preview和o1-mini两个版本。

它尤其擅长处理数学和编程问题,OpenAI直言,o1在物理、生物和化学问题基准测试中的准确度超过了人类博士水平。

比如,o1在美国数学奥林匹克资格赛中跻身美国前500名学生之列;在Codeforces比赛中达到了第89个百分位。

(o1-preview、o1-mini和人类能力对比,来源:OpenAI)

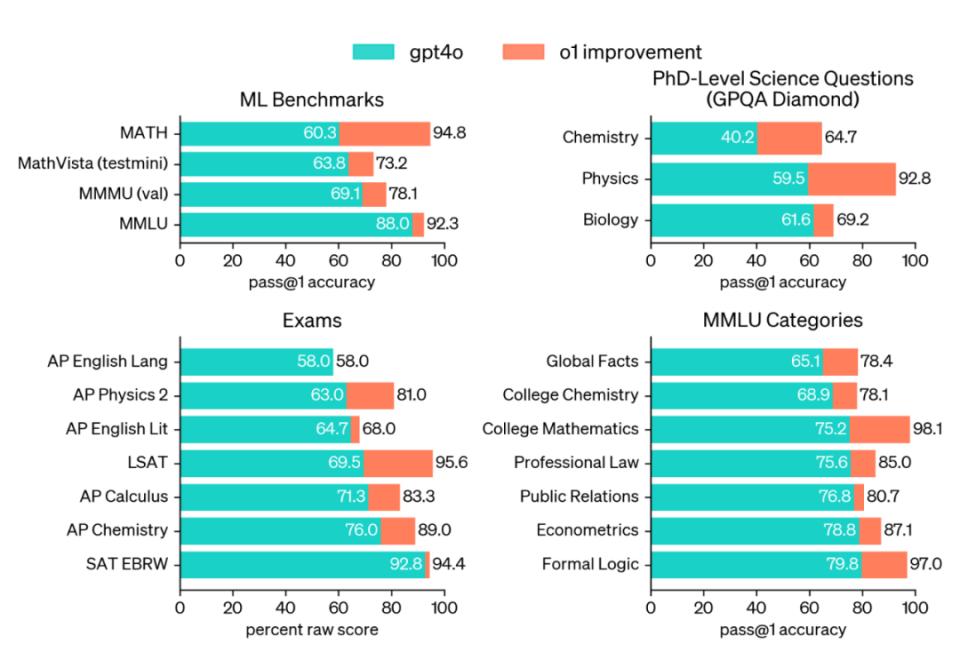

(GPT-4o和o1基准测试对比,OpenAI)

o1就像一位优秀的理科生,它擅长解决严谨的、有固定答案的推演问题。

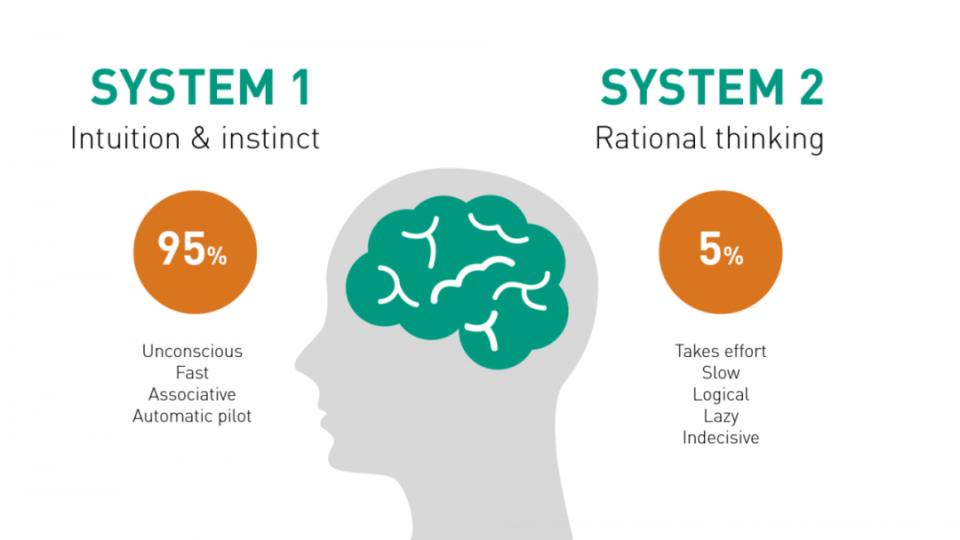

如果分析o1的思考模式,它对应的是心理学家丹尼尔·卡尼曼(Daniel Kahneman)提出的System 2(逻辑系统),其启动是被动、缓慢又耗时的,但这样的系统只占据人类整体思考的5%。而人类95%思考方式都归属于System 1(直觉系统),即根据直觉和经验的即时性本能思考。

来源:心理学家丹尼尔·卡尼曼(Daniel Kahneman)

o1所提升的准确性,还无法渗透System1(直觉系统),它像一个聪明的理科博士,但身上又欠缺了一些烟火气,很难通过直觉和经验角度提供没有幻觉的准确答案,所以距离真正的AGI还有不小的距离。

如果AGI是我们所仰望的星空,那么当下可以脚踏实地思考的是:OpenAI o1到底能给我们带来什么?它掀起的Self-play RL会成为大模型新的技术范式吗?行业玩家会跟随它的步伐吗?

Sam Altman历经数月种植的“草莓”,终于到了收获的季节,让我们一起品一品这颗草莓的味道。

1 OpenAI o1背后可能的技术是什么?

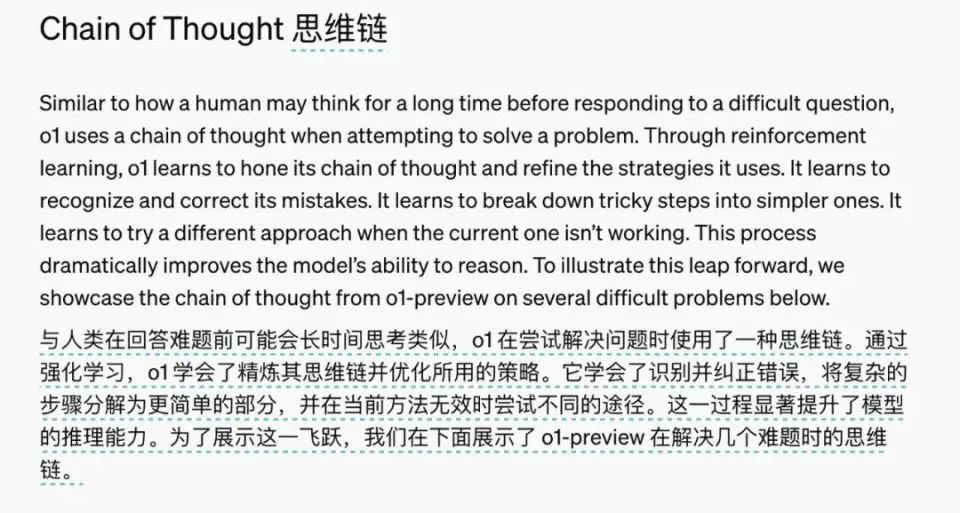

本次新品发布后,OpenAI在其官方博客简述了o1背后的核心技术提升:“通过强化学习,o1 学会了精炼其思维链并优化所用的策略。它学会了识别并纠正错误,将复杂的步骤分解为更简单的部分,并在当前方法无效时尝试不同的途径。这一过程显著提升了模型的推理能力。”

在这段叙述中我们可以看到o1的三个主要新能力:内化了思维链(COT)、能纠错、能尝试不同的途径。这些基本上与近几日业界讨论甚多的SelfPlay-RL(自我对弈型强化学习)的基本能力很符合。

虽然OpenAI没有详细的技术文档,但它的老对手谷歌在8月发布的一篇文章《Scaling LLM Test-Time Compute Optimally can be More Effective than Scaling Model Parameters》,提供了这种新的SelfPlay RL范式的一些基本框架和实现可能。

从中我们可以一窥o1可能的架构和逻辑。

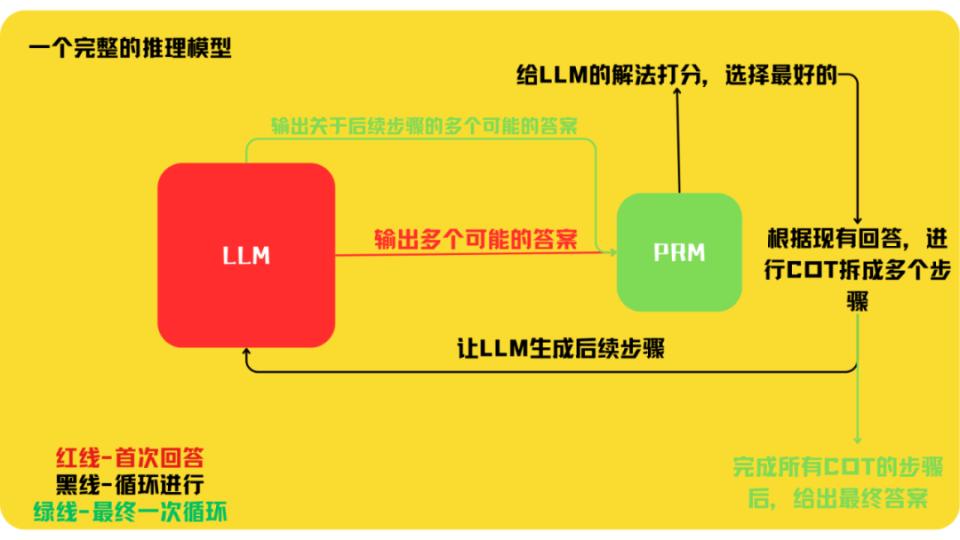

在这篇论文中谷歌详细解释了一种 PRM(Process reward model 过程奖励模型)作为和LLM(大语言模型)对弈的对手,它的推理模式和其效果。

PRM是在思维链的过程中给出奖励(打分)的模型,过程奖励模型。

它是一个单独被训练出来的模型,它拥有两个能力,一个是将问题拆成一步一步的思维链的能力;另一个是对大模型生成的每一步进行打分,并在结果不够理想时让大模型重新生成结果。它不仅可以评判每一个具体回答的优与劣,也可以评判在整个思维链过程中最佳的流程。

(绿的就是PRM觉得好的,红的就是觉得不行的)

它在与大模型的互动中,通过让大模型搜索多个可能的答案,在推理过程中的整体逻辑和每一步上都选择最佳的答案。这就让推理的准确性得到大幅提升。

(LLM与PRM进行对弈的流程示意图)

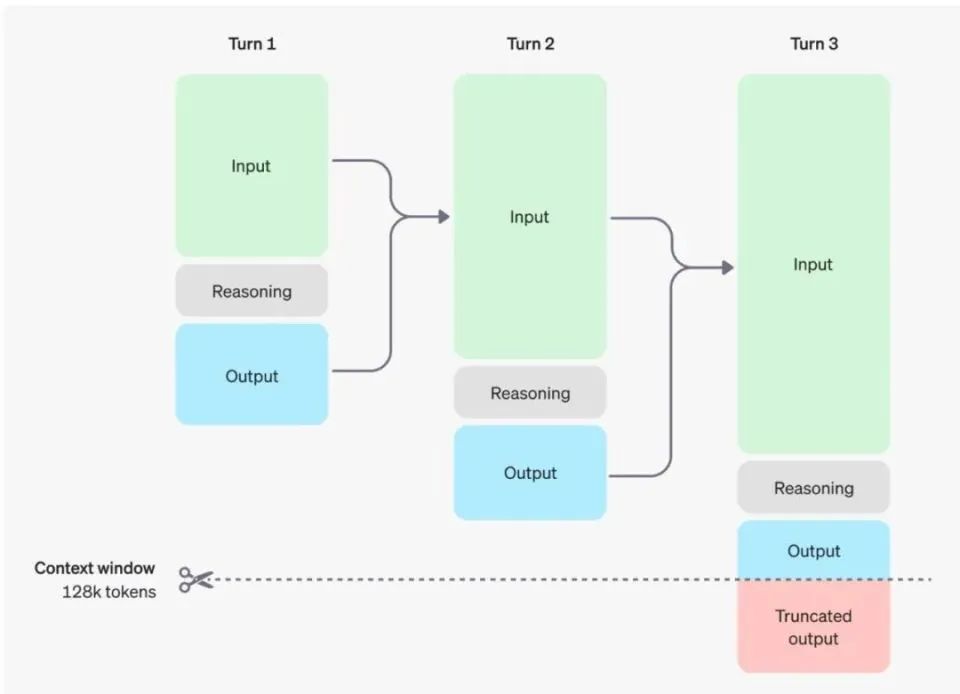

这一过程与OpenAI在“推理模型”中显示的多步循环对弈的形式也基本一致。在这张图里,模型在给出最终回答之前会进行三轮推理,并把前一轮的推理作为Input(输入)再给到下一轮。如果把它想象成思维链,这个输入就是对前一个步骤的对弈结果的总结。它最终输出的是一个简短的版本。

(OpenAI官网推理模型的多轮对弈模式)

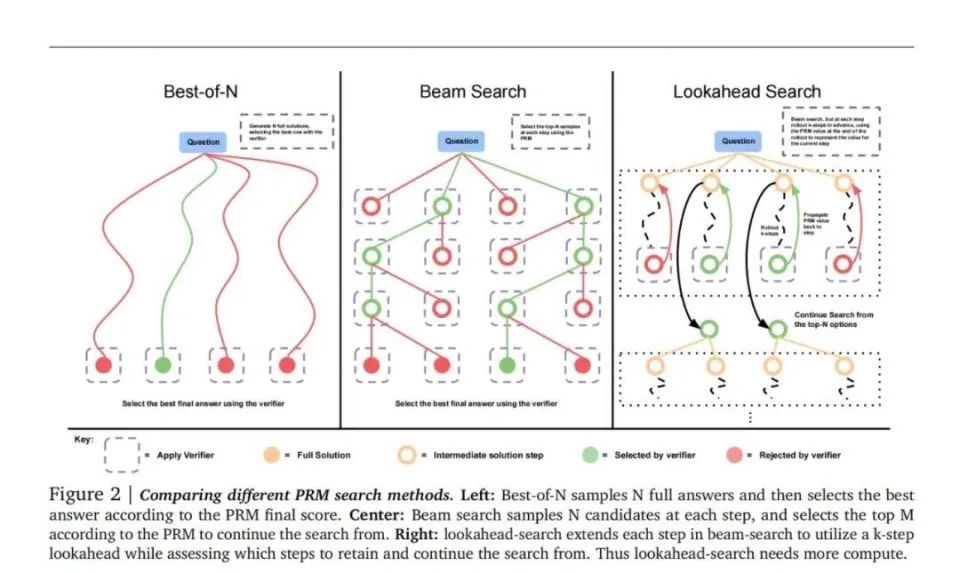

在这个过程中,PRM让LLM 去搜索最佳答案的方法也不同。

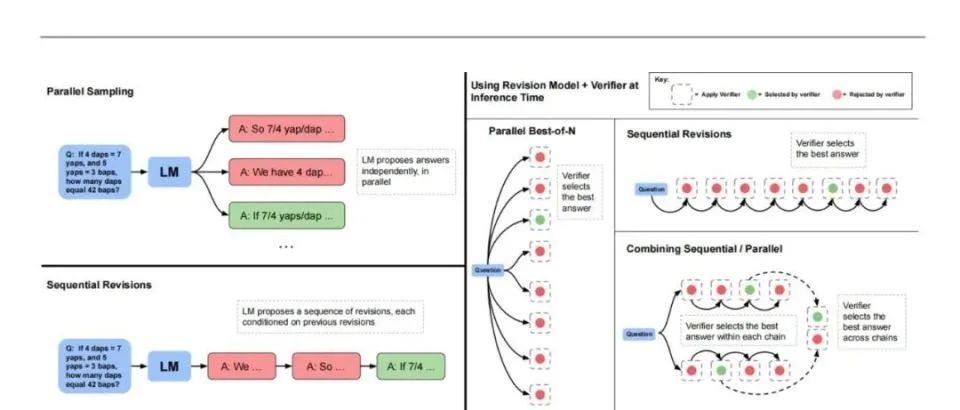

Google在研究中提到了从简单到复杂的三种方案,直接在多个答案中选最佳解的方法(Best of N),在思维链中每步都提供多个候选项的方法(Beam Search)和把后续多个步骤联系起来看的MCTS方法(蒙特卡洛树状搜索算法)的简化版本Lookahead Search。

那OpenAI最有可能选择的搜索模式是什么呢?

我们从反应时间和token消耗两方面看,根据Hackernews上一名使用了API的开发者的推算,OpenAI o1进行推理所消耗的token数量是其给出答案token的10倍。但可能会达到未进行思维链的GPT-4o mini 所用token数的60-100倍。

而如果采用能看三步的、每步形成5个候选选项情况下,单层深度的Lookahead Search就会消耗45倍的token。但用到了思维链每个步骤都需要进行一次Lookahead Search的话,100倍的token是根本打不住的。因此OpenAI o1所用的选择方法肯定不是MCTS形式的。另外考虑到这么MCTS这么大的计算量,目前o1的反馈时间是远远不够的。

但OpenAI o1也不可能是单纯的仅给出单个答案的思维链判断。仅用思维链,对于非常复杂的问题,token消耗最多也就是达到5-10倍。其60倍token消耗又太大了。因此可能有两种情况,一是PRM仅在答案不可接受或者低分太低时拓展进行MCTS式的搜索。或者它用的是更节约的Beam Search的方法搜索可能答案。但具体其结构,还有等到有更多OpenAI相关剧透才能认定。

这就是我们目前猜测的OpenAI o1的可能的技术架构。

对于OpenAI是否是训练了一个同时能做到思维链和判定的模型,而非一个PRM+LMM的模型组合这点。这其实并无必要。

首先,无论如何该模型都需要扮演两个角色(生成者和裁判)来完成强化学习的过程。而从性价比来讲,训练一个单独的PRM显然比训练一个GPT-4o大小的模型要节约的多。在谷歌的论文中,他们采用的是Palm 2-s这个最小的Palm 2模型进行的训练。

虽然谷歌的文章是在8月份发布的,但关于PRM的早期探索,实际上还是要回归到OpenAI。早在2023年5月,Illya和其团队就已经思考出了PRM,并发明出了这一结合思维链及监督者为一体的强化学习方法。

范式转变的种子,可能从那个时期就留下了。反思近期Illya在采访中提到的”每个人都在说“Scaling up”,但每个人都忽略了一个问题:我们在Scaling什么?可能就是意指这个从预训练到 推理 Scaling up的转变。

但目前OpenAI o1的效果很难说得上惊艳,虽然在很多复杂问题上能表现的超越GPT-4o,但仍然会在9.11和9.8谁大这样的问题上犯错误,会出现比较严重的思维链离题幻觉。

所以即使是OpenAI,经过一年多时间的尝试,其结果也不过如此。想走这条路,确实不太容易。

2 OpenAI o1更贵了吗?

相比较于OpenAI以往的版本,OpenAI o1的性价比优势并不明显。

OpenAI的收费类型有两种:面向普通用户的订阅制收费,以及面向开发者的API收费。

如果你已经是ChatGPT Pro的订阅用户,可以无缝衔接继续享受OpenAI o1,不用额外付费,也可以变相地认为,20美金可以使用OpenAI o1一个月。

但如果奔着OpenAI o1付费,就显得不那么划算,因为o1-preview每周只允许使用30条,o1-mini每周的使用上限是50条。如果想要好好做数学题,往往还没做完一套卷子,提问次数就已被消耗殆尽了。

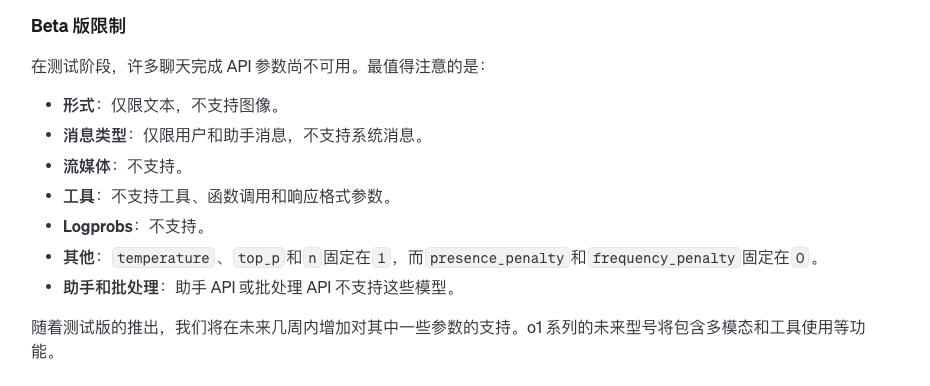

如果你是购买API的开发者用户,就要做好“花重金”的准备。首先,你的身份得是一个“5级API使用量”,它的意思是,你得已经消费1000美元以上并且是超过1个月的付费用户,有了这层身份,才拥有OpenAI o1的使用资格。

但即便你是这样的超级VIP用户,也只能使用“阉割版”,不支持图像、不支持系统消息和流媒体,也不支持函数调用。

即便有这么多的限制,API的价格也丝毫不比之前的版本便宜,你必须接受OpenAI价格的“屠刀”。

单从输出价格来看,o1-preview版的API就是4o的四倍,并且,一定要注意用(max_completion_tokens参数)限制token用量。

在之前的模型版本里,参数控制生成的token数量和用户可见的token数量始终相等,但是,在o1系列中,由于内部推理token的存在,生成token的总数可能会超过可见token的总量。如果不注重限制token数量,你可能会因为推理过程中多出来的token量,莫名提升使用成本。

根据Hacker News评测,API最终使用成本可能比GPT-4o高出1000倍。与此同时,也能看出OpenAI在推理成本上确实下了本,高达60美元/百万token。

3 OpenAI o1会带来哪些变革?

从范式革命的角度上看,这毫无疑问是一场革命。

它至少为困于数据和基建无法快速提升预训练规模的模型公司们提供了一个新的角度,从推理侧和强化学习的方法入手,加强模型的能力。

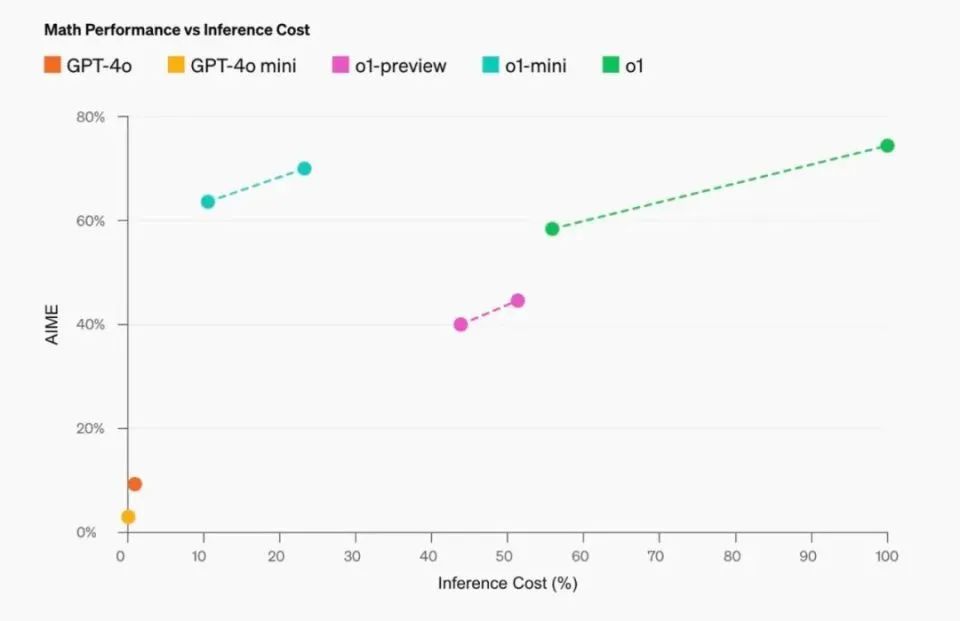

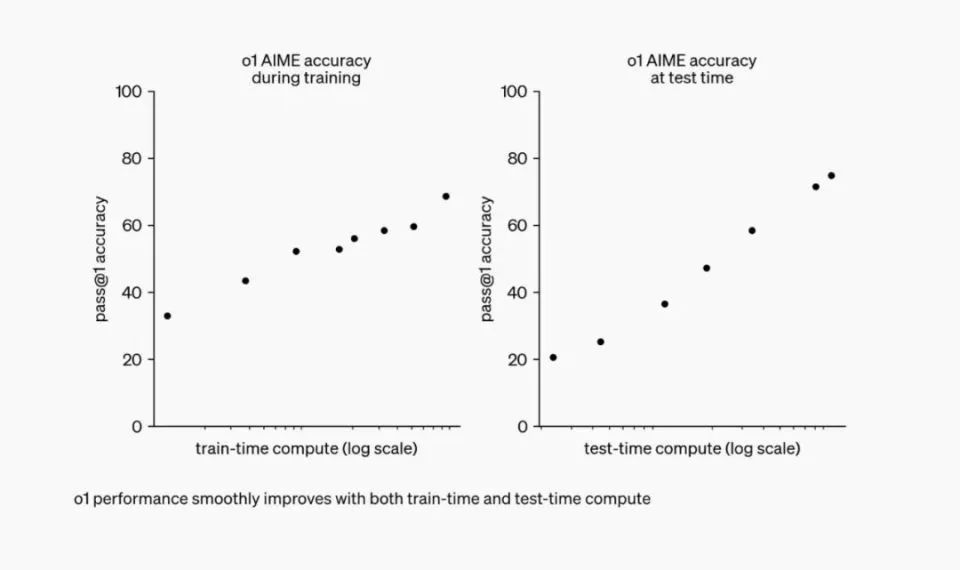

(随着更多强化学习(训练时计算)和更多思考时间(测试时计算)的投入,o1 的性能持续提升,但推理能力的加强比起预训练的加强增量更明显)

这也是为什么OpenAI 将它从GPT系列中独立出来,单独成一个新系列的原因。就是为了摆脱GPT(Generative pre-trained transformer)这个名字过分强调预训练(Pre -trained)的意味。而是让它更成为一个更强调推理能力训练的模型系列。

虽然之前Claude Sonnet也尝试过用强化学习提升其模型能力。但因为其反馈时间和token消耗并没有显著增加,因此它更可能用的是利用强化学习的模式积累思维链数据,再利用这些合成数据训练模型的模式。

因此,OpenAI o1确实是第一个“推理模型”。

但我们需要思考的是,为什么关于结合一个评价者(Verifer),乃至PRM的强化学习研究在这一年时间里汗牛充栋,却没一个公司敢做这个模型?当年做出AlphaGO的Deepmind在和Google AI合并时,大家就期待会有大模型和强化学习的结合。结果并没有。

首要原因是因为它太贵了,并且太慢了。

其次就是它的用处没那么大。一个作为Reward Model(奖励模型)的PRM模型,最重要的是能给LLM产生出的可能性打分。而能判断哪种回答更好的条件是什么?是最好是有答案。在数学和编程这样的领域,我们有明确的对和错的答案。但在其他领域,这些答案往往是模糊的,最优解的路径也不够清晰。

因此即使GPT-o1在编程和数学,以及同样可以形式化的,有最优解的物理、化学领域有了很大提升,它在其他领域的表现依然平平。它学到的逻辑能力并没有被泛化,也很难泛化。

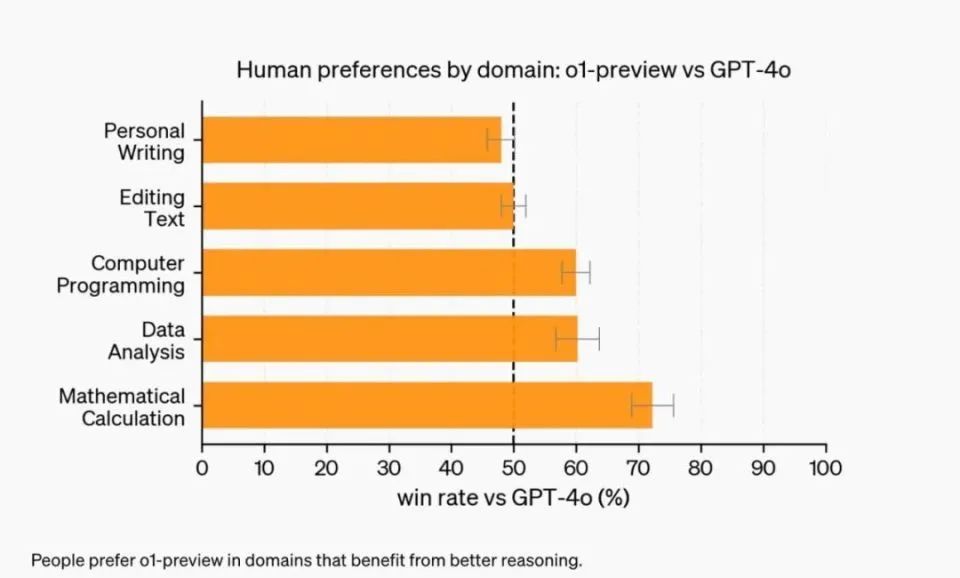

(与GPT 4o相比,o1在文本写作及处理上甚至因为强烈的幻觉有倒退)

也许它确实可以成为编程和数学研究的利器,但这个应用场景离我们期待的AGI太远了。

当然,依靠现实世界的基本事实,在比如说医疗这样有明确结果(治好、没治好)的领域进行训练,它也可以得到一定程度的能力延展。而对于非常复杂,基本上我们都没有通用思维链的领域,比如金融、文学创作上,它能带来的提升确实有限。现在它还只能被称为“领域推理模型“,而非通用推理模型。

但也许,如果Scaling Law真的也能应用于推理能力的话,当o1积攒的思维链数据飞轮足够多时,我们也能迎来在System 2这一侧的涌现。因此它确实是有效的范式变革。

比如最近谷歌的新论文 Generative Verifier 中,通过把 Verifier (评判者)也改变成一个预测的自回归模型,他们可以把问题每一步都用数值和文字评估。拓展了形式语言的限制。而且这个Verifier也可以直接结合思维链,成为一个PRM。

而对于嗷嗷待哺,需要更强应用界来讲,这一范式变化当下对他们带来的改进非常有限。因为它自己大概率就是个由PRM和LLM组成的Agent系统,想要好好利用它,很可能要改变目前做Agent的工作流。

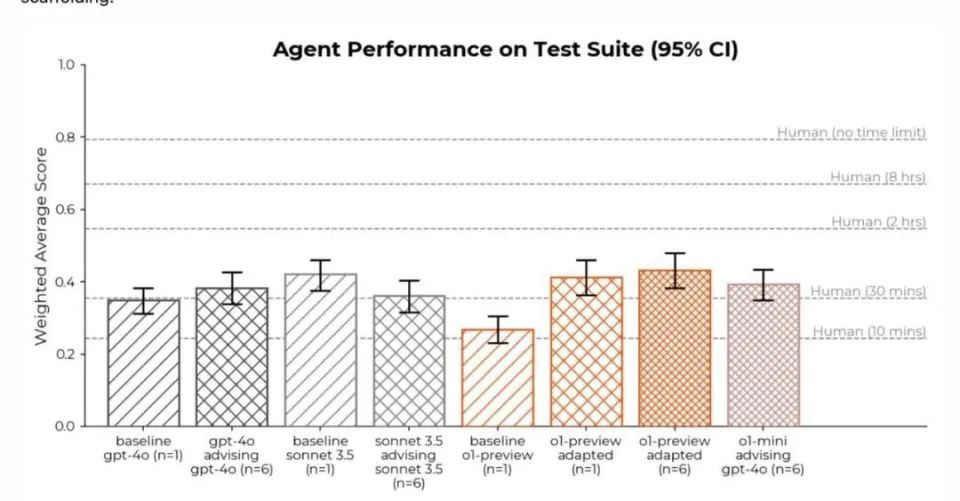

因此在研究机构METR发布的报告中,将o1-Preview作为Agent组件运用,其表现甚至低于GPT-4o。乃至经调试后效果也不过追平Claude Sonnet。这和大家期待的更强的基础模型能带来应用的提升也相去甚远。

(METR的结论)

对于Cursor这样目标在编程领域的公司来讲,o1的到来毫无疑问是一剂强心剂。他们在最近的论文《PlanSearch》论文里正在找适合自己的PRM模式。

仔细想想,其实OpenAI这就是在搭建一个通用Agent框架。而大多数应用开发者在做的,就是搭建一个面向特定领域的Agent工作流。虽然o1现在仅仅可用于数学、编程、物理这样的领域,而且是个缺乏搜索、调用工具能力的。但在OpenAI o1的研究参与者访谈中,研究人员就谈到,希望也可以把这种能力用在像编故事这类更有创造力的领域。

真是如此,恐怕又该有一票做Agent应用的创业者要失业了。

4 为什么不叫“草莓”,也不叫“GPT”?

对于新模型的名字为什么叫OpenAI o1,我们可以拆分来看。

OpenAI在官网上明确回复了名字中“1”的来源:“对于复杂的推理任务来说,这是一个重大进步,代表了人工智能能力的新水平。鉴于此,我们将计数器重置为1,并将该系列命名为“OpenAI o1”。

虽然OpenAI没有进一步解释名字中为什么带“o”,但我们可以衍生出几种合理的猜测。

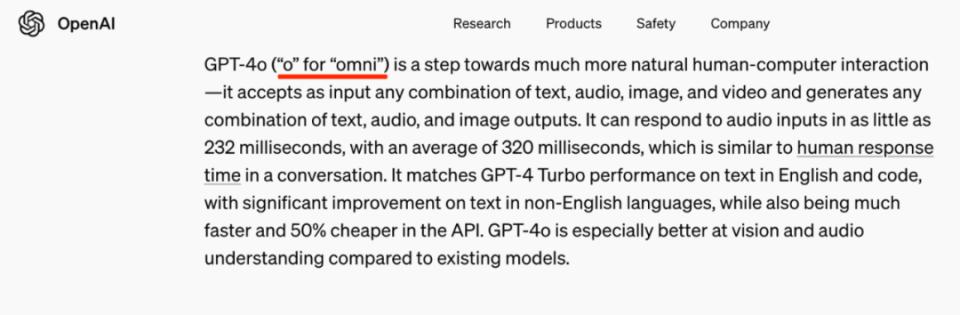

第一种猜测是,它沿袭了上一代模型GPT-4o中的“o”,OpenAI在今年5月份公布GPT-4o模型的时候提到,“o”代表“omni”,意思为“全能”,反应模型的多模态能力。

但这一次的o1模型仅支持文本,并没有展现多模态的能力,所以更倾向于另一种猜测:它代表“Orion(猎户座)”,也是OpenAI放风会成为GPT-4继任的模型,它比“草莓”模型要更上一层,根据The Medium报道,在强化推理能力的基础上,猎户座承载着OpenAI降低模型“幻觉”、提升模型可靠性的希望。

这就解释了OpenAI o1名字的大致由来,它预示着OpenAI提高模型准确性、降低幻觉的新开始。

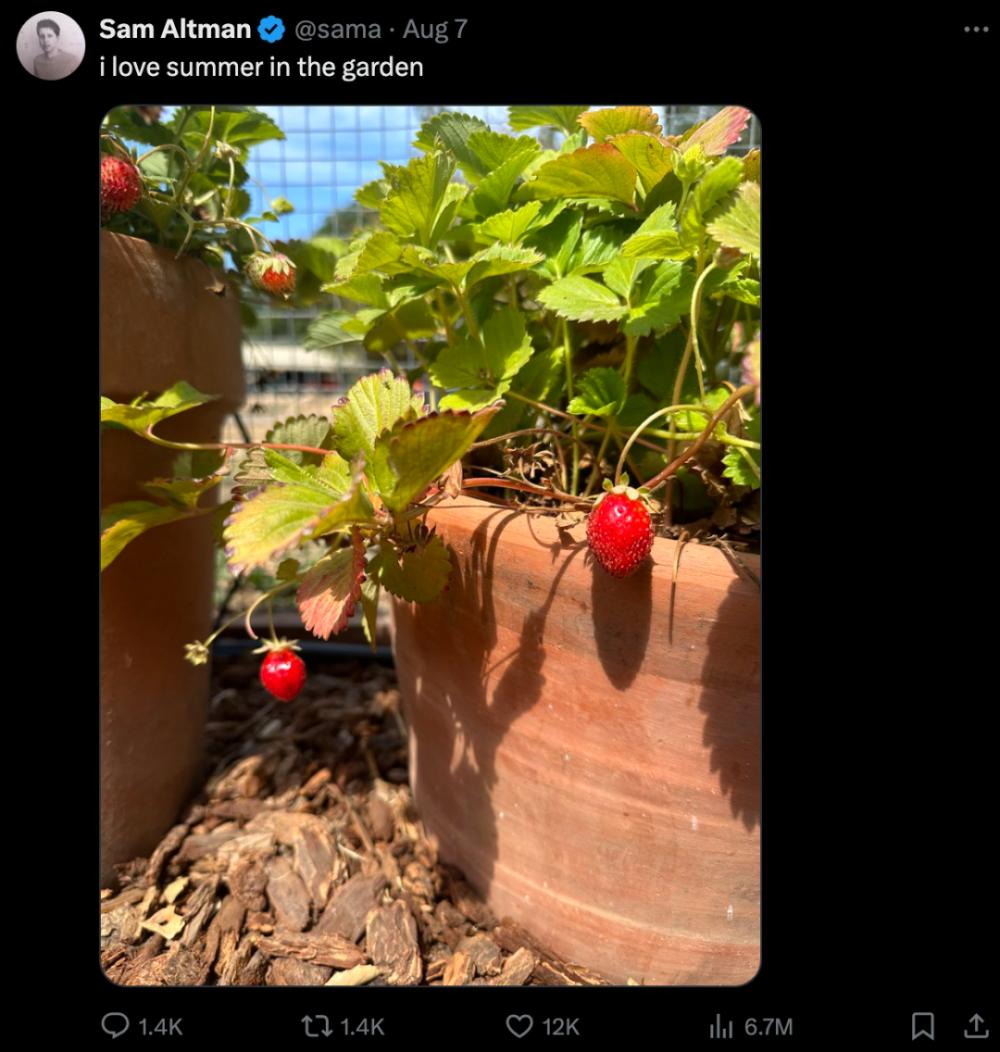

但是为什么在发布之前,又盛传新模型名字是“草莓”?今年8月份,Sam Altman在X上晒一张草莓果实图,一度被外界误认为由大模型生成,Sam Altman后澄清它确实是自家花园的真草莓。

与此同时,有一种说法,草莓成熟需要历经6周左右的时间,而从Sam Altman发布X的日期8月7日,到新模型正式发布的9月12日,中间相隔的时间正好接近6周。

(Sam Altman在X上发布自家花园的草莓)

虽然,“草莓”没有成为Sam Altman最终选定的模型名称,但这段有点浪漫的情节,造就了OpenAI的一段营销佳话。

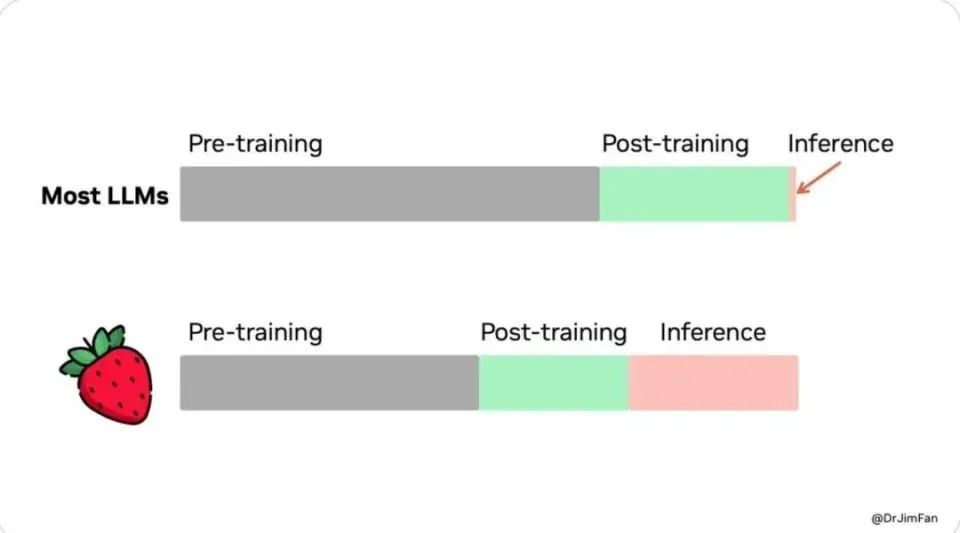

还有一个细节是,这次的模型名称完全没有了“GPT”三个字母的影子,其中“P”代表“Pre-trained”(预训练),英伟达高级研究科学家Jim Fan在X上透露,相比以往的大模型,o1模型弱化了“预训练”的环节,而提升了“推理”环节。

(Jim Fan在X上发布关于模型“预训练”份量对比图)

总的来看,“OpenAI o1”这个名字尽管略有拗口,但充满了美好的寓意。

5 结语

在现实生活中,更聪明、掌握信息更多的让往往会成为掌握资源最多的人。但在AI的世界里,也许你不用成为那个“最聪明”的人,而是成为最懂如何利用好“最聪明”工具的人,就可以掌握最多的资源。

这很符合人类的情绪价值——造出一个比自己聪明百倍千倍的新物种,同时它又不构成破坏性。

按照OpenAI的说法,o1的理科水平已经超过人类博士了,可以想象,一个小学生指挥AI“博士”帮自己做题的画面,在极大程度上满足了人类的需求。它们既能解决问题,又能提供情绪价值。

或许,这是除了“大脑”,人类也同样执着于打造和自己长得酷似的机器人的原因。未来比你聪明的“人”,可能真的成为对你百依百顺的工具,人们希望尽情享受这种,驾驭比你厉害的人带来的快感。

很显然,OpenAI已经在提供这种快感的道路上。

引文链接:

https://platform.openai.com/docs/guides/reasoning

https://openai.com/index/introducing-openai-o1-preview/