IT之家 12 月 18 日消息,科技媒体 9to5Mac 昨日(12 月 17 日)发布博文,报道称苹果公司开源名为 SHARP 的新型 AI 模型,该技术能在一秒内将单张 2D 照片转换为逼真的 3D 场景。

IT之家援引博文介绍,苹果发布名为《一秒内实现清晰的单目视图合成》(Sharp Monocular View Synthesis in Less Than a Second)论文,详细介绍了如何训练模型,在接收用户输入的一张普通 2D 照片后,能在一秒钟内重建出具有真实物理比例的 3D 场景。

与需要数分钟甚至数小时处理的传统方案相比,SHARP 将合成速度提升了三个数量级,实现了近乎实时的 3D 转换体验。

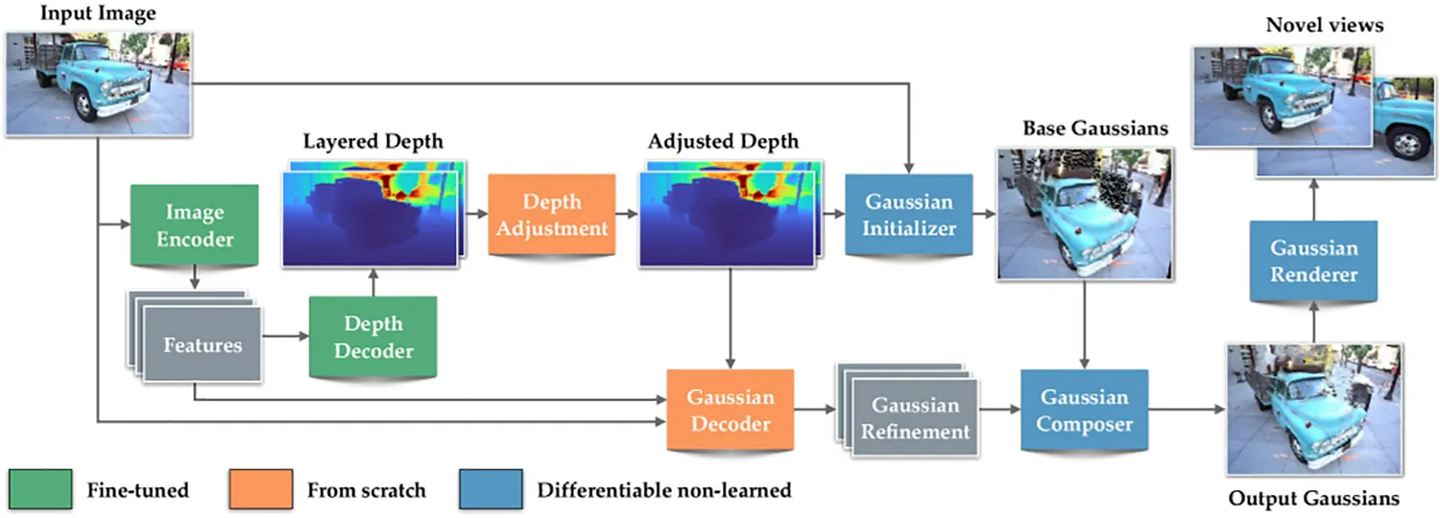

在技术原理上,SHARP 采用了先进的 3D 高斯泼溅技术(3D Gaussian Splatting)。简单来说,它将 3D 场景视为无数个带有颜色和光影信息的“模糊光团”(高斯球)。

传统的 3D 重建通常需要对同一场景拍摄数十甚至上百张不同角度的照片,再通过复杂的计算来确定这些光团的位置。然而,苹果通过使用海量的合成数据与真实世界数据训练 SHARP,让其掌握了通用的深度与几何规律。

因此,当面对一张全新照片时,SHARP 能通过神经网络的单次前馈传递,直接预测出数百万个 3D 高斯球的位置与外观,瞬间完成建模。

除了速度惊人,SHARP 在成像质量上也树立了新标杆。根据苹果公布的论文数据,该模型在多个基准测试数据集上均取得了优异成绩。

与此前业内最强的模型相比,SHARP 将 LPIPS(一种感知图像块相似度度量标准)降低了 25 个百分点至 34%,同时将 DISTS(纹理相似度指标)降低了 21 个百分点至 43%。这意味着,由 SHARP 生成的 3D 视图在细节纹理和整体结构上都更接近真实世界,且具备绝对尺度,支持真实的相机移动模拟。

不过,SHARP 目前仍存在一定的物理限制。为了保证生成的真实性与速度,该模型主要侧重于重建拍摄视角附近的 3D 视图,而不会凭空“脑补”照片中完全被遮挡或未拍摄到的盲区。

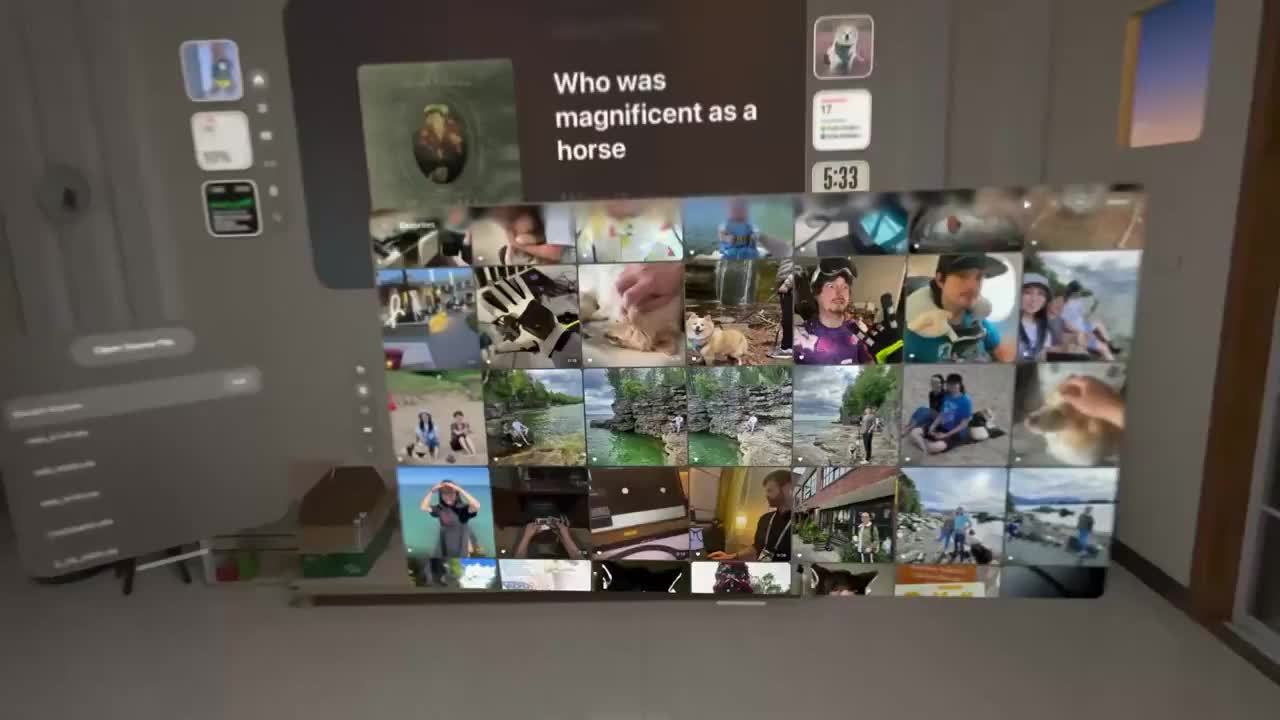

因此,用户在浏览生成的 3D 场景时,视角移动范围需保持在原图拍摄位置的邻近区域。苹果目前已将 SHARP 的完整代码及相关资源发布在 GitHub 平台,全球开发者均可下载测试,这一举措预计将大幅加速移动端 3D 内容创作与空间计算应用的发展。

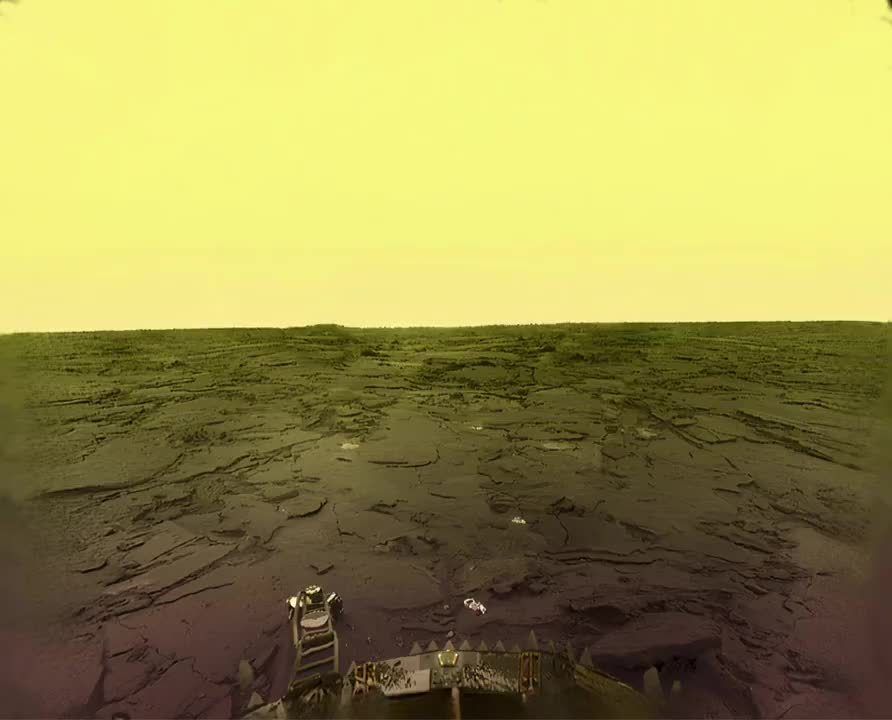

IT之家附上网友利用该模型,生成的 3D 场景如下: