英伟达开源 OCR 代码推理 AI 模型:LiveCodeBench 基准超 OpenAI o3-Mini 和 o1(low)

15 小时前

/ 阅读约3分钟

来源:IT之家

英伟达开源其 Open Code Reasoning(OCR)模型套装,含 32B、14B 和 7B 三种参数规模,均采用 Apache 2.0 许可证发布,模型权重和配置已在 Hugging Face 平台开放下载。

IT之家 5 月 9 日消息,科技媒体 marktechpost 昨日(5 月 8 日)发布博文,报道称英伟达开源其 Open Code Reasoning(OCR)模型套装,含 32B、14B 和 7B 三种参数规模,均采用 Apache 2.0 许可证发布,模型权重和配置已在 Hugging Face 平台开放下载。

OCR 模型套装提供三种参数规模,分别为 OpenCodeReasoning-Nemotron-32B、14B 和 7B,均使用 Nemotron 架构(一种为多语言、多任务学习优化的 transformer 框架)训练。

32B 模型面向高性能推理和研究场景,提供顶尖效果;14B 模型在降低计算需求的同时保持强大推理能力;7B 模型则适合资源受限的环境,仍能在基准测试中展现竞争力。

此外,32B 模型还推出了指令微调版本,支持与开放推理生态系统无缝兼容,适配 llama.cpp、vLLM、Hugging Face Transformers 和 TGI 等主流框架,方便开发者快速集成。

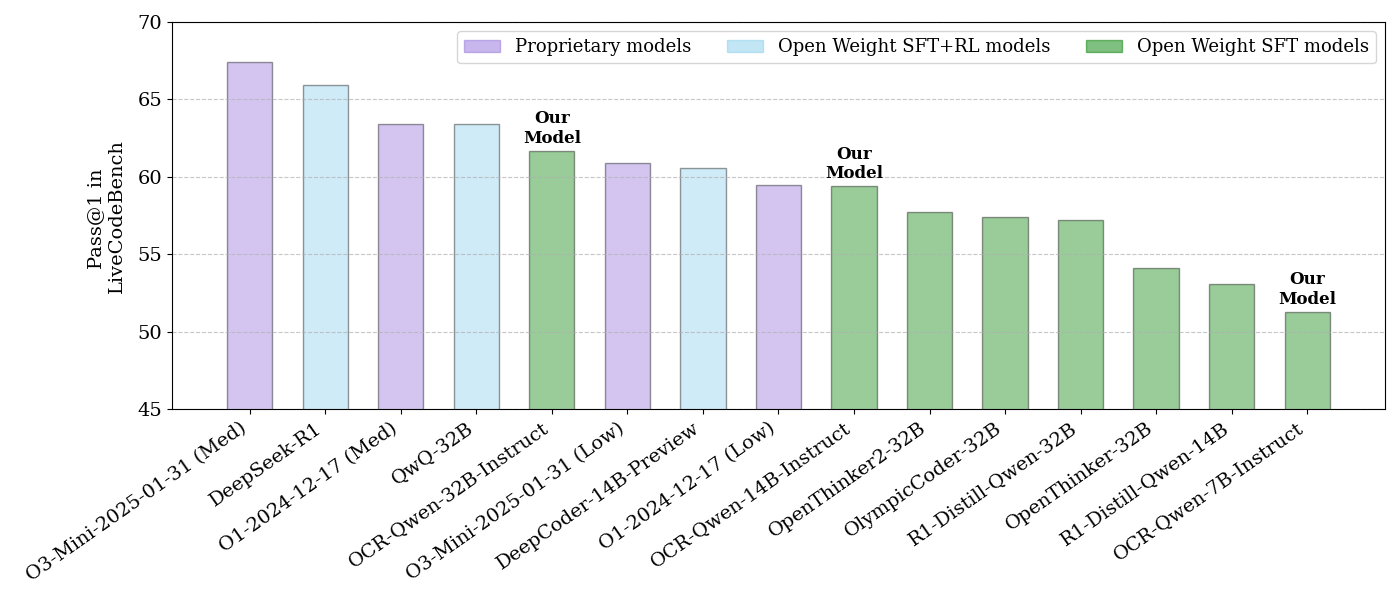

Open Code Reasoning(OCR)模型套装在代码推理领域展现出惊人实力。在 LiveCodeBench 基准测试中,这套模型全面超越 OpenAI 的 o3-Mini 和 o1 (low) 模型。

| Model | LiveCodeBench Avg. | CodeContest All |

|---|---|---|

| DeepSeek-R1 | 65.6 | 26.2 |

| QwQ-32B | 61.3 | 20.2 |

| Distilled 7B+ Models | ||

| Bespoke-Stratos-7B | 14.7 | 2.0 |

| OpenThinker-7B | 25.5 | 5.0 |

| R1-Distill-Qwen-7B | 38.0 | 11.1 |

| OlympicCoder-7B | 40.9 | 10.6 |

| OCR-Qwen-7B | 48.5 | 16.3 |

| OCR-Qwen-7B-Instruct | 51.3 | 18.1 |

| Distilled 14B+ Models | ||

| R1-Distill-Qwen-14B | 51.3 | 17.6 |

| OCR-Qwen-14B | 57.7 | 22.6 |

| OCR-Qwen-14B-Instruct | 59.4 | 23.6 |

| Distilled 32B+ Models | ||

| Bespoke-Stratos-32B | 30.1 | 6.3 |

| OpenThinker-32B | 54.1 | 16.4 |

| R1-Distill-Qwen-32B | 58.1 | 18.3 |

| OlympicCoder-32B | 57.4 | 18.0 |

| OCR-Qwen-32B | 61.8 | 24.6 |

| OCR-Qwen-32B-Instruct | 61.7 | 24.4 |

IT之家注:LiveCodeBench 是一个综合评估平台,专注于调试、代码生成和逻辑补全等真实开发者环境中的任务。

这一成就不仅得益于模型架构的优化,还归功于英伟达打造的定制“OCR 数据集”。该数据集聚焦高质量代码训练,强调指令遵循、推理能力和多步骤问题解决能力。